Não deixe o GPT-4 evoluir novamente! Musk assumiu a liderança ao assinar uma carta conjunta de milhares de pessoas, pedindo urgentemente aos laboratórios de IA que suspendessem imediatamente as pesquisas.

Até agora, vivemos muitas revoluções digitais, incluindo o surgimento de interfaces gráficas, o nascimento da Internet e a popularização da Internet móvel, mas nenhuma mudança tecnológica causou pânico tão generalizado quanto a onda de IA desencadeada pelo GPT modelo.

Por um lado, a IA mudou a maneira como as pessoas trabalham e vivem, melhorando muito a eficiência; por outro lado, a operação e o desenvolvimento da IA estão cheios de incertezas, o que aciona o mecanismo de proteção natural do ser humano contra coisas desconhecidas – o medo.

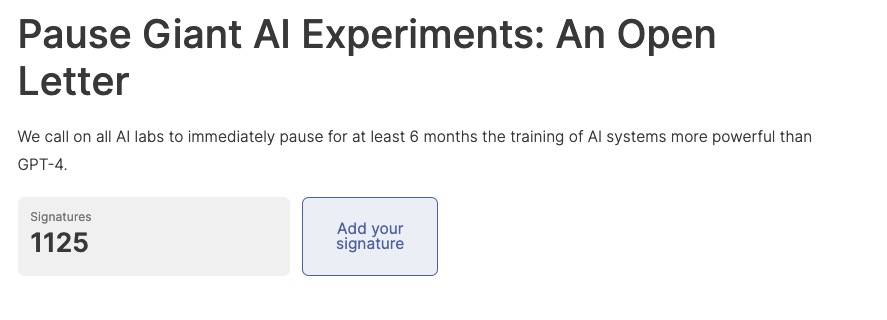

Hoje, uma carta conjunta pública na Internet explodiu, pedindo que todos os experimentos de IA suspendessem imediatamente a pesquisa em modelos de IA mais avançados que o GPT-4 por pelo menos 6 meses, a fim de matar essas terríveis fantasias no futuro.

A velocidade do progresso da IA é surpreendente, mas os métodos relevantes de supervisão e auditoria não acompanharam, o que significa que ninguém pode garantir a segurança das ferramentas de IA e o processo de uso de ferramentas de IA.

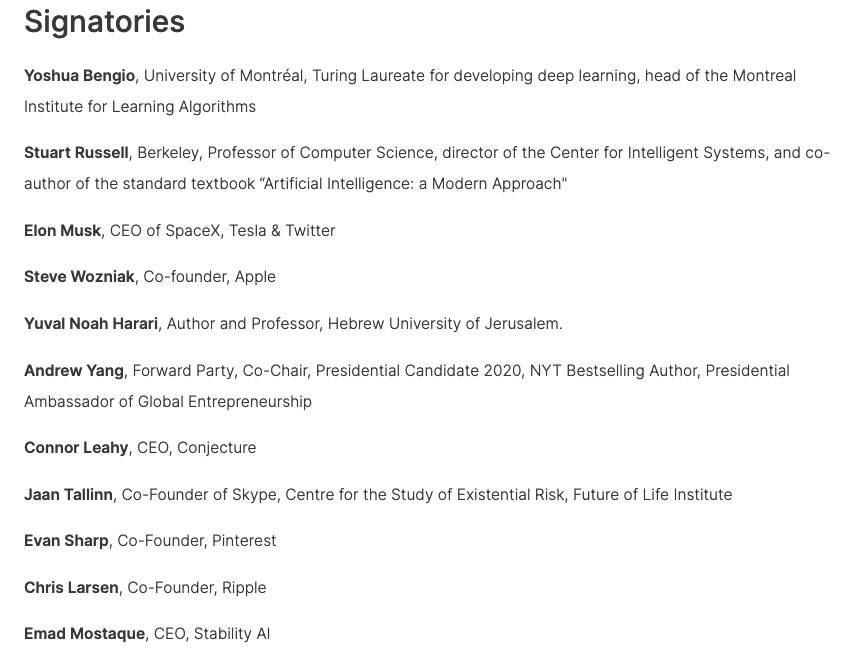

A carta conjunta recebeu o apoio da assinatura de muitas figuras conhecidas, incluindo o vencedor do Prêmio Turing de 2018, Yoshua Bengio, Musk, Steve Wozniak, cofundador do Skype, cofundador do Pinterest, CEO da Stability AI, etc., o número de co-signatários atingiu 1125 antes do prazo.

O texto original da carta aberta é o seguinte:

A inteligência artificial possui inteligência para competir com os seres humanos, o que pode trazer riscos profundos para a sociedade e para os seres humanos, o que tem sido confirmado por um grande número de estudos [1] e reconhecido pelos principais laboratórios de IA [2]. Como afirmam os amplamente reconhecidos Princípios de IA de Asilomar, a IA avançada pode representar uma grande transformação na história da vida na Terra e, como tal, deve ser planejada e gerenciada com atenção e recursos proporcionais.

Infelizmente, mesmo nos últimos meses, os laboratórios de IA travaram uma corrida desenfreada para desenvolver e implantar mentes digitais cada vez mais poderosas que ninguém pode entender, prever ou controlar de forma confiável, mesmo que os criadores também não pudessem fazer isso.

Com sistemas de IA modernos agora competitivos com humanos em tarefas comuns [3], devemos nos perguntar:

- Devemos permitir que as máquinas inundem nossos canais de informação, espalhando propaganda e mentiras?

- Devemos automatizar todos os trabalhos, incluindo os satisfatórios?

- Devemos desenvolver mentes não humanas que possam eventualmente nos superar e substituir?

- Devemos arriscar sair do controle da civilização?

Essas decisões não devem ser tomadas por líderes tecnológicos não eleitos. Somente quando estivermos confiantes de que o impacto do sistema de IA é positivo e os riscos são gerenciáveis, devemos desenvolver sistemas de IA poderosos. Essa confiança deve ser bem fundamentada e crescer com o impacto potencial do sistema. A recente declaração da OpenAI sobre inteligência artificial afirma que "em algum momento, pode ser necessário obter uma revisão independente antes de iniciar o treinamento de sistemas futuros e, para esforços de ponta, concordar em limitar a taxa de crescimento da computação usada para criar novos modelos." Concordamos. Agora é esse momento.

Portanto, pedimos uma moratória imediata em todos os laboratórios de IA por pelo menos 6 meses para treinar sistemas de IA mais poderosos que o GPT-4. Essa suspensão deve ser pública e verificável e incluir todos os principais participantes. Se tal moratória não puder ser implementada rapidamente, o governo deve intervir e impor uma moratória.

Laboratórios de IA e especialistas independentes devem usar essa pausa para trabalhar juntos para desenvolver e implementar um conjunto compartilhado de protocolos avançados de segurança de design e desenvolvimento de IA que devem ser rigorosamente revisados e monitorados por especialistas externos independentes.

Esses protocolos devem garantir que os sistemas que aderem a eles sejam seguros além de qualquer dúvida razoável [4]. Isso não significa interromper o desenvolvimento da IA, mas simplesmente dar um passo para trás na sempre perigosa corrida em direção a modelos de caixa preta maiores e imprevisíveis e suas capacidades emergentes.

A pesquisa e o desenvolvimento de IA devem se concentrar em melhorar a precisão, segurança, explicabilidade, transparência, robustez, alinhamento, confiabilidade e lealdade dos sistemas robustos e avançados existentes.

Ao mesmo tempo, os desenvolvedores de IA devem trabalhar com os formuladores de políticas para acelerar drasticamente o desenvolvimento de sistemas de governança de IA. Estes devem incluir pelo menos:

- Um novo órgão regulador competente dedicado à IA;

- Supervisão e rastreamento de sistemas de IA de alta capacidade e grandes pools de poder de computação;

- Sistemas de proveniência e marcas d'água para distinguir o conteúdo real do sintético, rastreando vazamentos de modelos;

- Ecossistema robusto de auditoria e certificação; responsabilidade pelos danos causados pela IA;

- Financiamento público adequado de pesquisa técnica de segurança em IA;

- Instituição veterana que lida com as enormes mudanças econômicas e políticas que a IA causará, especialmente as implicações para as democracias.

A humanidade pode desfrutar de um futuro próspero com a ajuda da IA. Tendo conseguido criar poderosos sistemas de IA, agora podemos desfrutar de um "verão de IA", no qual colhemos os frutos do uso desses sistemas explicitamente para beneficiar a todos e dar à sociedade uma chance de se adaptar.

A sociedade apertou o botão de pausa diante de outras tecnologias que poderiam ter efeitos catastróficos na sociedade [5]. Aqui podemos fazer o mesmo. Vamos aproveitar um longo verão de IA em vez de correr para o outono despreparados.

Informação de referência:

[1]

Bender, EM, Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021, março) Sobre os perigos dos papagaios estocásticos: os modelos de linguagem podem ser muito grandes?In Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparence (pp. 610-623).

Bostrom, N. (2016). Superinteligência. Oxford University Press.

Bucknall, BS, & Dori-Hacohen, S. (2022, julho). IA atual e de curto prazo como um potencial fator de risco existencial. In Proceedings of the 2022 AAAI/ACM Conference on AI, Ethics, and Society (pp. 119 -129).

Carlsmith, J. (2022). Is Power-Seeking AI an Existential Risk?. arXiv preprint arXiv:2206.13353.

Christian, B. (2020). O problema do alinhamento: aprendizado de máquina e valores humanos. Norton & Company.

Cohen, M. e outros (2022). Agentes artificiais avançados intervêm na provisão de recompensa. AI Magazine, 43(3) (pp. 282-293).

Eloundou, T., e outros (2023) GPTs são GPTs: uma análise inicial do potencial de impacto de grandes modelos de linguagem no mercado de trabalho.

Hendrycks, D., & Mazeika, M. (2022). X-risk Analysis for AI Research. arXiv preprint arXiv:2206.05862.

Ngo, R. (2022). O problema de alinhamento de uma perspectiva de aprendizagem profunda. arXiv preprint arXiv:2209.00626.

Russell, S. (2019). Compatível com humanos: inteligência artificial e o problema do controle. Viking.

Tegmark, M. (2017) Life 3.0: Ser Humano na Era da Inteligência Artificial Knopf.

Weidinger, L. et al (2021). Riscos éticos e sociais de danos causados por modelos de linguagem. arXiv preprint arXiv:2112.04359.

[2]

Ordonez, V. e outros (2023, 16 de março). O CEO da OpenAI, Sam Altman, diz que a IA vai remodelar a sociedade e reconhece os riscos: 'Estou um pouco assustado com isso'. ABC News.

Perrigo, B. (2023, 12 de janeiro) O CEO da DeepMind, Demis Hassabis, recomenda cautela com a IA. Tempo.

[3]

Bubeck, S. e outros (2023). Sparks of Artificial General Intelligence: Early experiment with GPT-4. arXiv:2303.12712.

OpenAI (2023). Relatório Técnico GPT-4. arXiv:2303.08774.

[4]

Existe um amplo precedente legal – por exemplo, os amplamente adotados Princípios de IA da OCDE exigem que os sistemas de IA “funcionem adequadamente e não representem riscos de segurança excessivos”.

[5]

Os exemplos incluem clonagem humana, modificação da linhagem germinativa humana, pesquisa de ganho de função e eugenia.

Nesta carta aberta, o formulário de assinatura anexado pode ser mais emocionante do que o conteúdo da própria carta. Você pode encontrar muitos nomes familiares aqui, e cada assinatura expressa o forte ceticismo do signatário em relação à IA.

No entanto, alguns internautas acharam que essas assinaturas podem não ser totalmente credíveis, porque os nomes do CEO da OpenAI Sam Altman (eu me selei?) e do ator John Wick do filme "Quick Chase" apareceram na lista. ser estudado.

O endereço desta carta conjunta está anexado abaixo, e os amigos interessados também podem assinar seus nomes.

#Bem-vindo a prestar atenção à conta pública oficial do WeChat de Aifaner: Aifaner (ID do WeChat: ifanr), conteúdo mais interessante será apresentado a você o mais rápido possível.