Como o Google fez o efeito de luz retrato no Pixel 5?

Já ouvimos o termo fotografia computacional muitas vezes nos últimos dois anos.

Quando se trata de fotografia computacional, as pessoas pensam naturalmente na série de telefones celulares Pxiel do Google. Pode-se dizer que essa série cria um precedente para a fotografia computacional. Ela revela o poder e o charme da fotografia computacional.

É precisamente porque o poder da fotografia computacional é tão incrível que os fabricantes de telefones celulares, que gradualmente relembraram nos últimos dois anos, finalmente mergulharam nele. Neste momento, o Google já está jogando mais flores.

O "efeito de luz retrato" foi originalmente lançado com o lançamento do Pixel 4a e Pixel 5 pelo Google em outubro deste ano, que é o recurso exclusivo desta geração do Pixel. Mas, alguns dias atrás, o Google fez uma atualização nos aplicativos de câmera e álbum de fotos, delegando essa função aos usuários após o Pixel 2.

Inspirado nas luzes de fotografia usadas por fotógrafos de retratos, "Efeito de luz de retrato" pode reposicionar e modelar a fonte de luz e, em seguida, adicionar a nova fonte de luz à cena da foto. Ele também pode identificar a direção e intensidade da iluminação inicial e, em seguida, complementar automaticamente a situação de iluminação.

Essa poderosa função de fotografia computacional é naturalmente inseparável dos recursos de aprendizado de máquina das redes neurais. Depois que as fotos tiradas pelo modo de efeito de luz de retrato do celular são usadas como um banco de dados para treinamento, os recursos posteriores do "efeito de luz de retrato" permitem dois novos algoritmos:

- Adicionar fonte de luz sintética automaticamente: para uma determinada foto de retrato, o algoritmo irá sintetizar e adicionar a fonte de luz externa, e a iluminação e a iluminação do fotógrafo serão consistentes na realidade.

- Re-iluminação após a composição: para uma determinada direção de iluminação e foto de retrato, adicione luz composta da maneira mais natural.

Deixe-me falar primeiro sobre o primeiro problema, que é determinar a posição da fonte de luz e adicioná-la. Na realidade, os fotógrafos costumam adotar uma forma empírica e perceptiva, observando a intensidade e a posição da luz incidindo sobre a face do assunto, para então determinar como iluminá-la. Mas, para a IA, como determinar a direção e a posição da fonte de luz existente não é fácil.

Para isso, o Google adotou um novo modelo de treinamento de máquina – contornos de iluminação omnidirecionais. Este novo modelo de cálculo de iluminação pode usar o rosto humano como um detector de luz para inferir a direção, intensidade relativa e cor da fonte de luz de toda a iluminação, e também pode estimar a postura da cabeça na foto por meio de outro algoritmo facial.

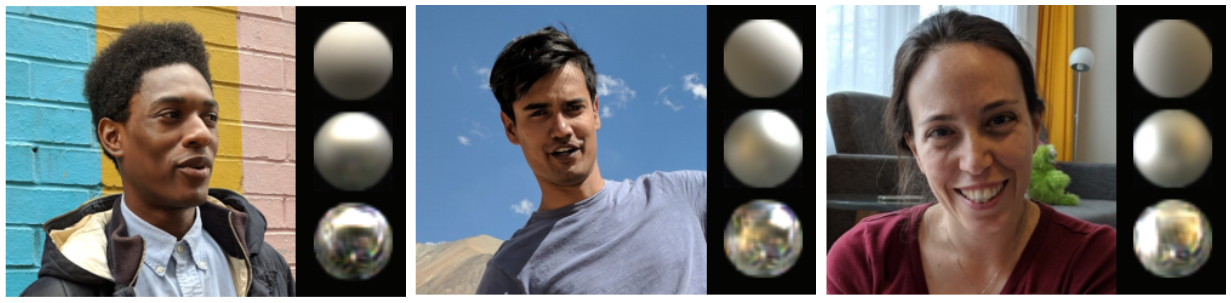

Embora pareça muito alto, o efeito de renderização do modelo de treinamento real é bastante adorável. Ele tratará a cabeça humana como três objetos esféricos prateados redondos, e a "textura" da bola superior é a mais áspera, usada para simular Reflexo difuso de luz. A bola no meio também é fosca, usada para simular uma fonte de luz mais concentrada. A bola inferior é o "material" do espelho, que é usado para simular um reflexo de espelho mais suave.

Além disso, cada esfera pode refletir a cor, intensidade e direcionalidade da iluminação ambiente de acordo com suas próprias características.

Dessa forma, o Google pode obter a direção da fonte de luz pós-composta. Por exemplo, a fonte de luz de retrato clássica está localizada 30 ° acima da linha de visão e entre 30 ° e 60 ° com o eixo da câmera. O Google também segue esta regra clássica.

Depois de aprender a direção de adicionar uma fonte de luz a um retrato, a próxima coisa a fazer é como tornar a fonte de luz adicionada mais natural.

A questão anterior é um pouco como "Dugu Nine Swords". Depois de aprendê-la, farei algumas questões fixas. Para resolver o último problema, é necessário fazer "Dugu Nine Swords" o máximo de combate real possível, para integrar diferentes situações reais e, então, aprender a quebrar as artes marciais do mundo.

Para resolver esse problema, o Google desenvolveu outro novo modelo de treinamento para determinar a fonte de luz autodirecional a ser adicionada à foto original. Em circunstâncias normais, é impossível treinar este modelo com os dados existentes, porque ele não pode enfrentar a exposição quase infinita à luz, e deve corresponder perfeitamente ao rosto humano.

Por esse motivo, o Google criou um dispositivo muito especial para treinar o aprendizado de máquina – uma "gaiola" esférica. Existem 64 câmeras com diferentes ângulos de visão e 331 fontes de luz LED individualmente programáveis neste dispositivo.

Se você já foi ao Dolby Cinema, existe um link no show de pré-exibição do Dolby Cinema onde o som se move em uma cúpula hemisférica para simular a direção quase infinita na realidade. O dispositivo Google, na verdade, tem um princípio semelhante.

Alterando constantemente a direção e a intensidade da iluminação e simulando fontes de luz complexas, você pode obter os dados da luz refletida do cabelo, pele e roupas humanos, de modo a obter como a iluminação deveria ser sob fontes de luz complexas.

O Google convidou 70 pessoas diferentes para treinar este modelo com diferentes formatos de rosto, penteados, cores de pele, roupas, acessórios e outras características. Isso garante que a fonte de luz sintetizada corresponda ao máximo à realidade.

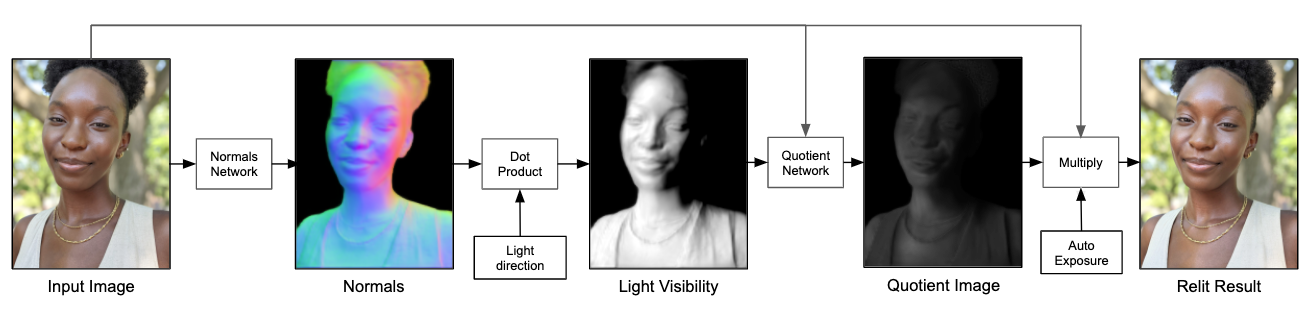

Além disso, o Google não produz diretamente a imagem final por meio do modelo de rede neural, mas permite que o modelo de rede neural produza uma imagem de quociente de resolução inferior.

Aqui está uma explicação do que é uma imagem quociente. Uma imagem pode ser dividida em duas camadas: a camada inferior e a camada de detalhes. A camada inferior contém as informações de baixa frequência da imagem, que refletem as mudanças de intensidade da imagem em grande escala; a camada de detalhes contém as informações de alta frequência da imagem, que refletem os detalhes da imagem em pequena escala. A camada inferior multiplicada pela camada de detalhes é a imagem de origem, e a camada de detalhes também pode ser chamada de imagem quociente.

Em seguida, através da camada inferior da imagem original, adicionando fontes de luz adicionais aos dados da imagem de quociente de entrada durante a amostragem, você pode obter uma imagem de saída final.

O processo final é assim. Primeiro, dada uma imagem, depois calcule a superfície normal do personagem na imagem, então calcule a fonte de luz visível na imagem e use o modelo de rede neural para simular a fonte de luz adicional para produzir uma imagem de quociente de resolução inferior e, em seguida, use-a como A camada de detalhes é multiplicada pela camada inferior da foto original e, finalmente, uma foto de retrato com fontes de luz adicionais é obtida.

O Google também fez muitas otimizações no pipeline para que os efeitos de luz simulados possam interagir em tempo real no celular, enquanto o tamanho de todo o modelo é de apenas cerca de 10 MB.

Pode-se dizer que o efeito de iluminação de retrato do Pixel 5 é um caso típico na fotografia computacional do Google. Por meio do treinamento contínuo de modelos de redes neurais, o telefone móvel pode simular a iluminação de retratos reais. Concluído um novo cenário de aplicação da fotografia computacional.

Algumas pessoas dizem que a fotografia é uma arte e a fotografia computacional é fundamentalmente um insulto à fotografia. Mas desde que o francês Daguerre fez a primeira câmera prática em 1839, a câmera está em uso há mais de 100 anos. Do nicho às massas, até o nascimento da câmera do celular, todos têm oportunidades quase iguais de tirar fotos. E as expressões interiores das pessoas também enriqueceram gradualmente a arte da fotografia.

Isso mesmo, a fotografia computacional é ao mesmo tempo que "fotografia" e também "sombras computacionais", mas os algoritmos há muito são uma parte inseparável da fotografia móvel. A busca ainda é o efeito que pode ser alcançado na realidade simulada. Afinal, ninguém o fará "Mudança mágica" é chamada de fotografia computacional.

Quando a Apple e o Google foram cada vez mais longe na fotografia computacional, descobrimos que os algoritmos são, na verdade, uma barreira mais forte do que o hardware.

#Bem-vindo a seguir a conta oficial do WeChat da Aifaner: Aifaner (WeChat ID: ifanr), mais conteúdo interessante será fornecido a você o mais rápido possível.