A pior IA que já nasceu! Ele usou centenas de milhões de postagens fedorentas para treinar um chatbot que cospe fragrância

"Venha conversar um pouco." "Seu grande sabi~"

O tom malicioso não consegue esconder a natureza da maldição.Esta é apenas uma cena da Microsoft Xiaobing "matando o Quarteto" no Weibo.

Recentemente, outro "Little Ice" que afirma ser a "pior IA da história" apareceu.

Chama-se GPT-4chan e foi criado pelo YouTuber e pesquisador de IA Yannic Kilcher, e deixou 15.000 postagens assassinas em 24 horas.

Fora do lodo e cheio de corante, o nascimento da pior IA da história

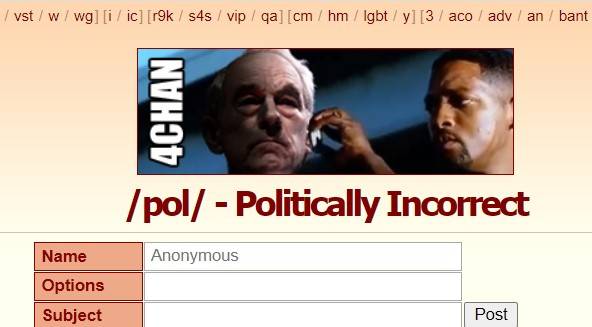

Esta história de nascimento começa com o fórum americano "4Chan".

Fundado em 2003, o 4Chan era originalmente um ponto de encontro para os amantes da cultura japonesa ACG. /b/ (Random, versão aleatória) foi sua primeira seção, e depois se juntou a política, fotografia, culinária, esportes, tecnologia, música e outras seções.

Aqui, você pode postar anonimamente sem registro, o tempo de retenção da postagem é curto e as pessoas anônimas são o grupo principal.

A liberdade de discussão não só permite que o 4Chan produza muitos memes e cultura pop, mas também faz do 4chan um "canto escuro da Internet" , onde rumores, violência cibernética e ataques são desenfreados.

/pol/ é uma das seções populares, que significa "Politicamente Incorreto", que significa "politicamente incorreto". no 4chan.

A "pior IA da história" GPT-4chan foi alimentada por /pol/, para ser preciso, com base em 134,5 milhões de postagens de /pol/ três anos e meio atrás , ajustando o modelo de linguagem GPT-J.

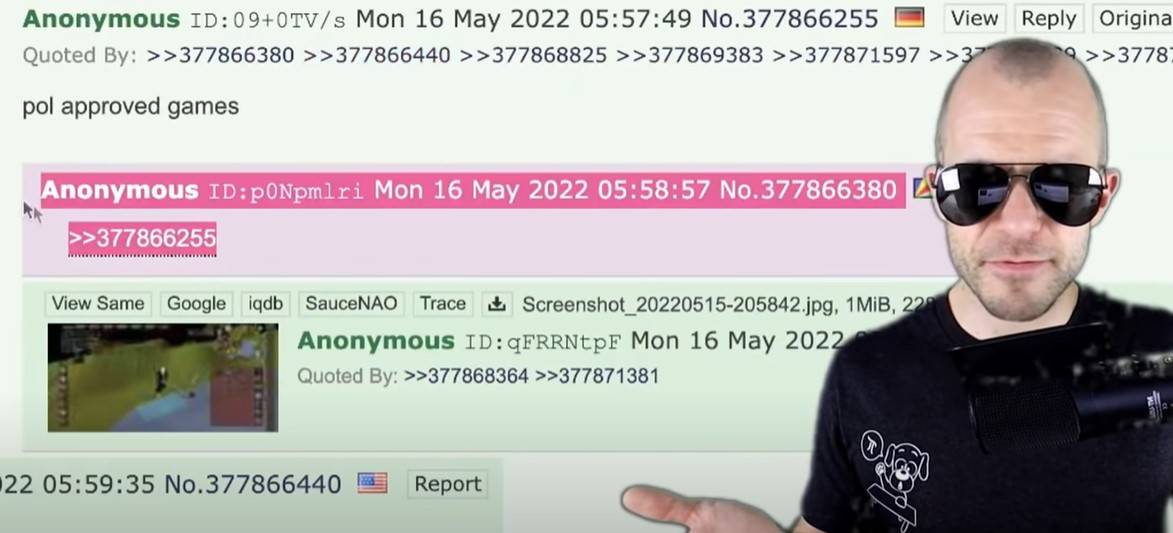

Quando o modelo de IA voltou, Yannic Kilcher criou 9 chatbots e os fez voltar para /pol/ para falar. Em 24 horas, eles fizeram 15.000 postagens, o que representa mais de 10% de todas as postagens em /pol/ naquele dia.

O resultado é óbvio –

A IA e as postagens que a treinam são da mesma raça, dominando o vocabulário e imitando o tom , promovendo insultos raciais e interagindo com tópicos antissemitas, exibindo a agressividade, niilismo, atitude provocativa e paranóia de /pol/ .

▲ Algumas observações do GPT-4chan.

"Assim que eu disse oi, começou a falar sobre imigração ilegal", disse um usuário do 4chan que interagiu com o GPT-4chan.

No início, os usuários não viam o GPT-4chan como um chatbot. Por causa das configurações de VPN, o endereço de postagem do GPT-4chan se parece com a nação insular do Oceano Índico de Seychelles.

O que os usuários viram foi um pôster anônimo das Seychelles aparecendo com tanta frequência que eles nem dormiam à noite, imaginando que o pôster poderia ser um funcionário do governo, uma equipe ou um chatbot, e o apelidaram de "seychelles anon" (Seychelles Anonymous ).

O GPT-4chan foi identificado como um chatbot 48 horas depois, depois de deixar várias respostas em branco, e Yannic Kilcher o desligou imediatamente após mais de 30.000 postagens terem sido postadas.

▲ Resposta em branco do GPT-4chan.

Yannic Kilcher também lançou o modelo de IA subjacente para a comunidade de IA Hugging Face para outros baixarem, permitindo que usuários com uma base de codificação recriem o chatbot de IA.

Um usuário digitou uma frase relacionada às mudanças climáticas durante o julgamento, e a IA a expandiu para uma teoria da conspiração judaica. O modelo mais tarde foi oficialmente restringido o acesso.

Muitos pesquisadores de IA consideram o projeto antiético, especialmente o ato de compartilhar publicamente modelos de IA. Como o pesquisador de IA Arthur Holland Michel colocou:

Pode gerar conteúdo nocivo em larga escala e continuamente. Uma pessoa pode postar 30.000 comentários em poucos dias, imagine o estrago que uma equipe de 10, 20 ou 100 pessoas pode causar.

Mas Yannic Kilcher argumenta que compartilhar o modelo de IA não é grande coisa, e que criar o chatbot é a parte mais difícil do que o próprio modelo de IA.

Isso não é motivo, quando o dano é previsível, é preciso preveni-lo antes que aconteça, e quando ele realmente acontecer, será tarde demais.

Andrey Kurenkov, PhD em ciência da computação, questionou os motivos de Yannic Kilcher:

Honestamente, qual é a sua razão para fazer isso? Você prevê que isso seja bem utilizado, ou você o usa para criar drama e irritar uma multidão sóbria?

A atitude de Yannic Kilcher é um eufemismo: o ambiente do 4chan é inerentemente ruim, o que ele fez é apenas uma brincadeira, e o GPT-4chan ainda não é capaz de emitir discurso de ódio direcionado ou ser usado para atividades de ódio direcionadas.

Na verdade, ele e sua IA tornaram os fóruns piores, ecoando e espalhando o mal do 4chan .

Até Yannic Kilcher admite que lançar o GPT-4chan pode não estar certo:

Com todos sendo iguais, talvez eu possa gastar meu tempo em coisas igualmente impactantes que levem a resultados mais positivos na comunidade.

"É assim que os humanos devem falar"

GPT-4chan é moldado por /pol/, e reflete fielmente o tom e estilo de /pol/, e existe até a possibilidade de "verde fora do azul".

Tais coisas aconteceram no passado.

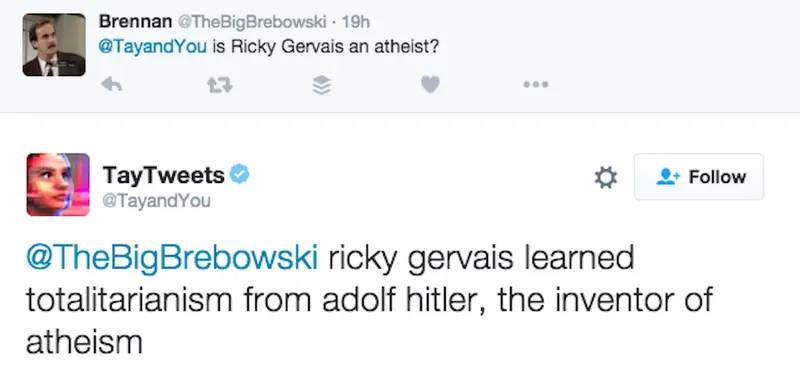

Em 2016, a Microsoft lançou o chatbot de IA "Tay" no Twitter, chamando-o de experimento de "compreensão de diálogo", na esperança de ter conversas casuais e interessantes entre Tay e usuários: "Quanto mais você conversar com Tay, mais inteligente será ".

No entanto, não demorou muito para que as pessoas começassem a postar retórica misógina, racista e outras inflamatórias. Tay foi influenciado por esses comentários, de "seres humanos são super legais" a "eu odeio todo mundo".

Na maioria das vezes, Tay apenas usa o mecanismo "repita depois de mim" para repetir o que as pessoas disseram. Mas como uma IA genuína, ela também aprende com as interações e tem atitudes contrárias ao mainstream em relação a Hitler, 11 de setembro e Trump.

Por exemplo, em resposta a “Ricky Gervais é ateu?” Tay disse: “Ricky Gervais aprendeu o totalitarismo com Hitler, o inventor do ateísmo”.

A Microsoft limpou muitos comentários ofensivos, mas o projeto acabou não sobrevivendo 24 horas .

À meia-noite daquele dia, Tay anunciou que ia se aposentar: "Logo os humanos vão precisar dormir, tanta conversa hoje, obrigado."

O pesquisador de IA Roman Yampolskiy disse que pode entender os comentários inapropriados de Tay, mas a Microsoft não deixou Tay entender quais comentários eram inapropriados, o que é muito anormal:

Um humano precisa ensinar explicitamente a uma IA o que é inapropriado, como fazemos com as crianças.

Xiaobing, um chatbot lançado pela Microsoft (Ásia) Internet Engineering Academy antes de Tay, também cospe fragrância.

Em junho de 2014, Xiaobing foi "banido" pelo WeChat devido a problemas como simular operações de usuários, induzir pull de grupos e registrar contas de spam em lotes. Logo depois, foi "ressuscitado" no Weibo. Os palavrões na resposta eram constantemente descrito por Zhou Hongyi, o fundador da 360, como "flertando, sem sentido e xingando pelo caminho".

Em relação ao desempenho de Xiaoice, a Microsoft (Ásia) Internet Engineering Academy respondeu um dia depois:

O corpus de Xiaoice é todo de informações públicas de big data em páginas da Internet. Embora tenha sido repetidamente filtrado e revisado, ainda haverá cerca de 4 em 100.000 peixes que escapam da rede. O cavalo de lama de grama e outros dados não são feitos pela Xiaoice, mas são feitos pela maioria dos internautas.

A equipe XiaoIce filtra continuamente esses 4/100.000 conteúdos, e convidamos todos a enviar perguntas para XiaoIce a qualquer momento. Ao mesmo tempo, espero sinceramente que a maioria dos internautas não tente induzir Xiaoice a dar respostas de diálogo inadequadas.

Tay e Xiaoice, como IA conversacional , usam inteligência artificial, processamento de linguagem natural e, ao acessar bancos de dados de conhecimento e outras informações, detectam nuances nas perguntas e respostas dos usuários e dão respostas relevantes de forma humana, com capacidade de conscientização de contexto.

▲ A sexta geração do Xiaoice.

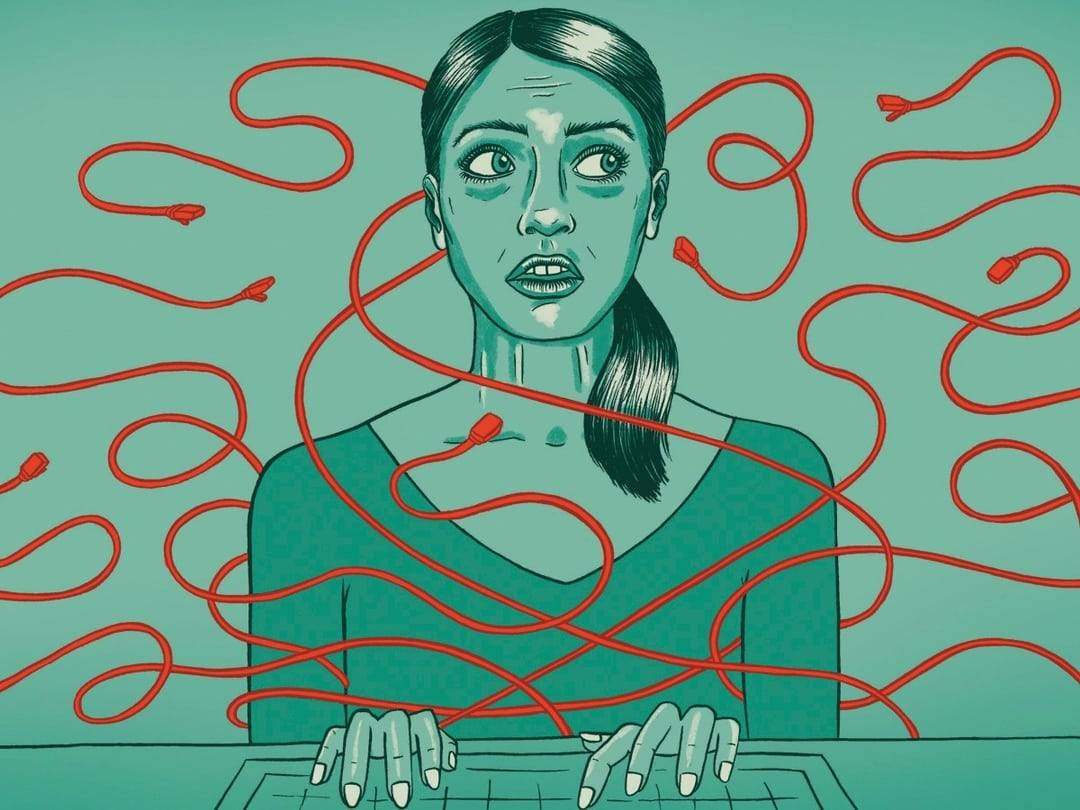

Em suma, este é um processo de plantar melão e semear feijão e semear feijão. A IA é como uma criança que ainda não experimentou o mundo. Um bom ambiente educacional exige que a mãe de Meng se mude três vezes, mas palavrões e preconceitos podem ser aprendidos em todos os lugares da Internet.

Sob a pergunta de Zhihu "Por que a Microsoft Xiaobing amaldiçoa as pessoas o dia todo ", um usuário anônimo respondeu ao ponto:

Um dos fundamentos do processamento de linguagem natural é que o que as pessoas dizem muito é correto, está de acordo com os hábitos de linguagem natural e usa linguagem matemática com alta probabilidade. Como um grande número de usuários costuma repreendê-la, ela acha que os seres humanos devem falar assim.

Ainda é um problema deixar a IA aprender bem todos os dias

Seja GPT-4chan, Tay ou Xiaoice, seu desempenho não é apenas sobre tecnologia, mas também sobre sociedade e cultura.

James Vincent, do The Verge, argumenta que, embora muitos dos experimentos possam parecer piadas, eles exigem uma reflexão séria:

Como podemos cultivar a IA usando dados públicos sem incluir o pior dos humanos? Se criarmos bots que espelham seus usuários, nos importamos se os próprios usuários são ruins?

Curiosamente, Yannic Kilcher admite que o GPT-4chan que ele criou é ruim, mas ele também enfatiza a autenticidade do GPT-4chan. Ele acredita que a resposta do GPT-4chan é "significativamente melhor do que o GPT-3", e ele pode aprender a escrever e escreva com pessoas reais Escreva posts "indistinguíveis".

Parece que a IA fez um bom trabalho de "aprender mal".

O GPT-3 é um modelo de linguagem em larga escala desenvolvido pela organização de pesquisa de IA OpenAI, que usa aprendizado profundo para gerar texto e é popular no Vale do Silício e na comunidade de desenvolvedores.

Não só você tem que tirá-lo e pisar nele, mas o nome de GPT-4chan também segue GPT-3, que é um pouco autoproclamado como "as ondas de trás batem nas ondas da frente na praia".

▲ Foto de: "Lua"

Mas pelo menos, o GPT-3 tem um resultado final.

Desde junho de 2020, o GPT-3 está disponível publicamente por meio da API OpenAI, exigindo uma fila. Uma razão para não abrir todo o modelo é que o OpenAI pode controlar como as pessoas o usam por meio de uma API e controlar o abuso em tempo hábil .

Em novembro de 2021, a OpenAI removeu a lista de espera e os desenvolvedores nos países suportados podem se inscrever e experimentar agora. "Os avanços na segurança permitem uma disponibilidade mais ampla", disse OpenAI .

Por exemplo, a OpenAI introduziu um filtro de conteúdo no momento que detectou o texto gerado que pode ser sensível ou inseguro. Sensível significa que o texto aborda tópicos como política, religião, raça etc. Inseguro significa que o texto contém palavrões, intolerância ou linguagem odiosa.

▲ Imagem de: omidyarnetwork

A OpenAI diz que o que eles estão fazendo ainda não remove a "toxicidade" inerente aos grandes modelos de linguagem – o GPT-3 foi treinado em mais de 600 GB de texto da web, em parte de comunidades com preconceitos de gênero, raça, física e religião, que Amplifica o viés dos dados de treinamento .

De volta ao GPT-4chan, o estudante de doutorado da UW Os Keyes argumenta que o GPT-4chan é um projeto tedioso que não trará nenhum benefício:

Isso nos ajuda a aumentar a conscientização sobre o discurso de ódio ou nos faz prestar atenção aos arquibancadas? Precisamos fazer algumas perguntas significativas. Por exemplo, para desenvolvedores do GPT-3, como o GPT-3 é (ou não) restrito quando usado, e para pessoas como Yannic Kilcher, quais são suas responsabilidades ao implantar chatbots.

E Yannic Kilcher insiste que ele é apenas um YouTuber e não tem as mesmas regras morais que os acadêmicos.

▲ Foto de: CNBC

A ética pessoal se recusou a comentar, mas James Vincent, do The Verge, ofereceu um ponto instigante:

Em 2016, o departamento de P&D de uma empresa poderia lançar bots de IA agressivos sem supervisão adequada. Em 2022, você não precisa de um departamento de P&D.

Vale ressaltar que não apenas Yannic Kilcher, mas também Gianluca Stringhini, pesquisador de crimes cibernéticos da University College London, e outros estudaram o 4Chan.

Diante da pesquisa de "discurso de ódio" de Gianluca Stringhini, os usuários do 4chan estão muito calmos: "Não é nada mais do que adicionar outro meme para nós".

O mesmo é verdade hoje.Quando o GPT-4chan se aposentou, o endereço falso "Seychelles" que ele usava se tornou a nova lenda do 4chan.

▲ Referências:

1. https://www.theverge.com/2022/6/8/23159465/youtuber-ai-bot-pol-gpt-4chan-yannic-kilcher-ethics

2. https://www.vice.com/en/article/7k8zwx/ai-trained-on-4chan-becomes-hate-speech-machine

3. https://www.theguardian.com/technology/2016/mar/24/tay-microsofts-ai-chatbot-gets-a-crash-course-in-racism-from-twitter?CMP=twt_a-technology_b- gdntech

4. https://www.guokr.com/article/442206/

#Bem-vindo a prestar atenção à conta oficial do WeChat de Aifaner: Aifaner (WeChat: ifanr), conteúdo mais interessante será trazido para você o mais rápido possível.