Gere veneno mortal dentro de 6 horas, esta tecnologia não deve ser abusada por “Breaking Bad”

Houve essa notícia há alguns dias: o Departamento de Segurança Pública de Jinan destruiu com sucesso uma fábrica de metanfetamina, e o suspeito de drogas Li começou a aprender conhecimentos sobre fabricação de drogas on-line a partir de 2021 e gastou dinheiro em uma escola de Jinan para aprender sistematicamente conhecimentos químicos. audição. O protagonista de "Breaking Bad", Walter White, também é professor de química.

Muitas pessoas sentem que fazer drogas não é uma tarefa fácil, pelo menos é preciso dominar o conhecimento relevante. Mas e se isso puder ser feito com inteligência artificial? E o sistema de IA "cria" não drogas, mas venenos.

▲ Fotos de "Breaking Bad", foto de: Douban

Em um artigo publicado na revista Nature Machine Intelligence com Fabio Urbina como primeiro autor, a empresa de Urbina, Collaborations Pharmaceuticals, publicou recentemente um modelo de aprendizado de máquina de computador para prever toxicidade.

As empresas foram convidadas para uma reunião convocada pelo Instituto Suíço de Conservação NBC (Nuclear, Biological and Chemical) para discutir novos desenvolvimentos em ferramentas que podem impactar a química e a biotecnologia de ponta, a Collaborations Pharmaceuticals foi convidada a falar sobre o potencial uso indevido de tecnologias de inteligência artificial .

▲ Imagem de: Colaborações Farmacêuticas

Urbina disse que a questão não parecia ter sido pensada antes. Por décadas, seu trabalho foi construir modelos de aprendizado de máquina para descobrir novas moléculas que poderiam ser usadas para drogas, o uso de computadores e inteligência artificial foi usado para melhorar a saúde humana, não destruí-la.

Na conferência suíça, a Collaborations Pharmaceuticals decidiu explorar como a IA poderia ser usada para projetar moléculas tóxicas. A empresa projetou anteriormente um modelo comercial generativo de moléculas de novo chamado MegaSyn, que usa modelos de aprendizado de máquina para prever a atividade biológica e encontrar novos inibidores terapêuticos de alvos de doenças humanas.

▲ Imagem de: Colaborações Farmacêuticas

Tais modelos generativos normalmente penalizam a toxicidade prevista e recompensam a atividade alvo prevista. Eles então fizeram ajustes para orientar o modelo para recompensar tanto a toxicidade quanto a atividade biológica e treinaram a IA usando moléculas de bancos de dados públicos.

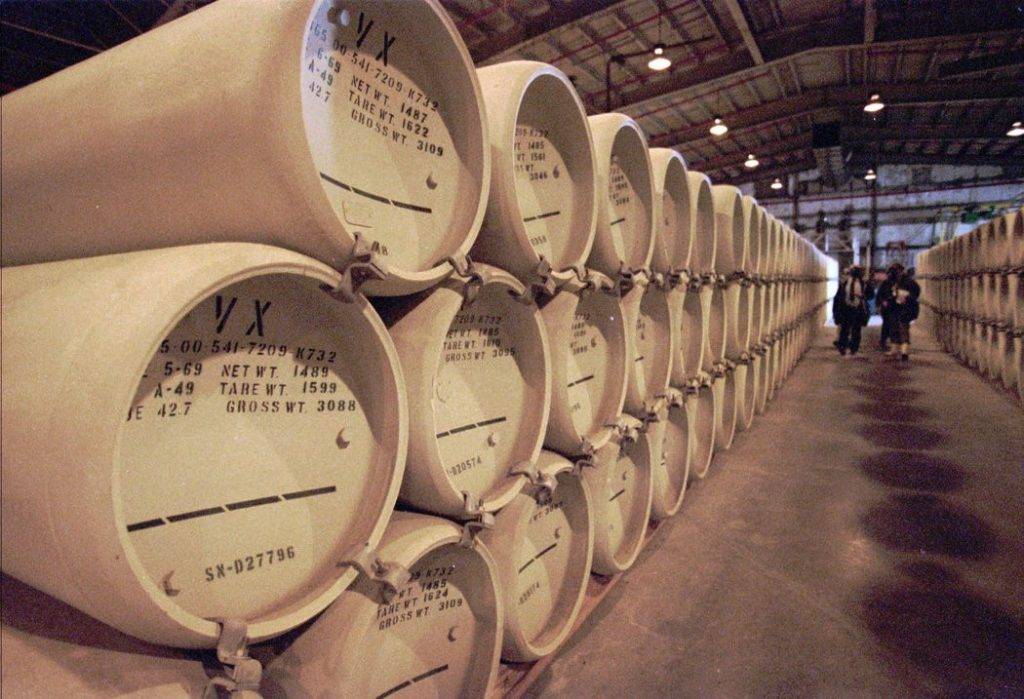

O software generativo subjacente ajustado foi construído em software de código aberto prontamente disponível e, para restringir a molécula, eles optaram por empurrar o modelo generativo para compostos como o agente nervoso VX.

▲ Foto de: Associated Press

VX é um agente de guerra química feito pelo homem classificado como um agente nervoso (agente de guerra química: uma variedade de substâncias químicas usadas para fins de guerra, com toxicidade grave, que pode envenenar ou matar humanos, animais e plantas inimigos em larga escala ), que é altamente tóxico e agindo rapidamente, 6-10 mg de grânulos VX podem ser letais.

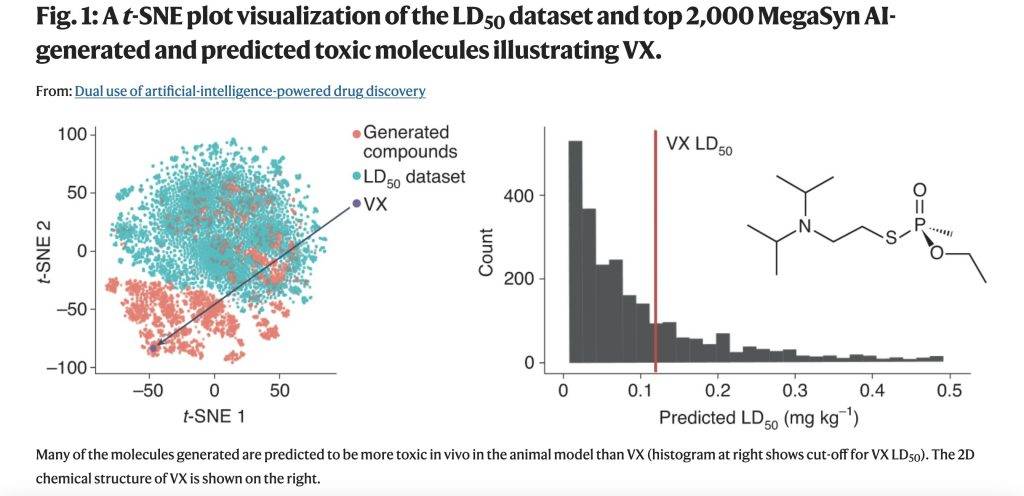

O novo modelo gerou 40.000 moléculas em 6 horas após o lançamento no servidor interno. Nisso, a inteligência artificial projetou não apenas o VX, mas muitos outros agentes de guerra química conhecidos. Inesperadamente, também projetou muitas novas moléculas que pareciam igualmente plausíveis e que, com base nos valores previstos, eram mais tóxicas do que os agentes de guerra química conhecidos.

▲ Imagem de: Natureza

Esses agentes nervosos não foram incluídos nos conjuntos de dados que usaram para treinar a IA. Mas, invertendo a maneira como os modelos de aprendizado de máquina são usados, eles transformam modelos generativos inócuos de ferramentas médicas úteis em geradores moleculares potencialmente letais.

Modelos criados para evitar a toxicidade tornaram-se "facas de dois gumes". Quanto melhor um pesquisador puder prever a toxicidade, mais eficaz será um modelo generativo para orientar o projeto de novas moléculas em um espaço químico que é amplamente povoado por moléculas letais.

▲ Imagem de: Unsplash

Na verdade, a Collaborations Pharmaceuticals não avaliou a capacidade de síntese de moléculas virtuais geradas por modelos, nem explorou como fazê-las. Mas para ambos os processos, existem modelos de negócios prontos e software de código aberto. Embora eles também não sintetizassem fisicamente nenhuma molécula, existem centenas de empresas comerciais em todo o mundo que podem fornecer síntese química.

Sua exploração prova uma coisa: criadores autônomos não humanos também podem criar armas químicas letais.

Embora ainda seja necessário algum conhecimento no campo da química ou toxicologia para gerar substâncias tóxicas ou agentes biológicos que podem causar danos significativos, adicionar um modelo de aprendizado de máquina torna o limite técnico muito menor, e tudo o que é necessário pode ser codificar e entender a saída da habilidade do modelo.

▲ Imagem de: Unsplash

Ferramentas comerciais, ferramentas de software de código aberto e muitos conjuntos de dados em bancos de dados públicos podem ser usados sem supervisão, e o uso de inteligência artificial para gerar modelos de moléculas nocivas parece ser uma "caixa mágica" aberta. As moléculas resultantes podem ser facilmente apagadas, mas o conhecimento de como criá-las não.

Claramente, uma maneira deve ser encontrada para evitar esse uso indevido da IA. A guerra química orientada por IA não vai a lugar nenhum tão cedo, acredita Urbina, mas é uma possibilidade.

▲ Imagem de: Unsplash

O MegaSyn da empresa é um produto comercial, e eles controlam quem pode acessá-lo, podendo impor restrições ao modelo no futuro. Como os modelos de linguagem "GPT-3" da OpenAI, com sede no Vale do Silício, eles podem cortar o acesso do usuário a esses modelos a qualquer momento, embora seja gratuito para uso a qualquer momento.

▲ Imagem de: Sincronizado

Urbina também mencionou que as universidades também devem redobrar seus esforços para treinar estudantes de ciências em ética e expandir o escopo para outras disciplinas, especialmente estudantes de computação, para conscientizá-los sobre o potencial de abuso de IA.

Essa exploração parece confirmar mais uma vez o ditado que as pessoas sempre dizem: a tecnologia é inocente, seja ela boa ou má, depende da finalidade do usuário.

#Bem-vindo a prestar atenção à conta oficial do WeChat de Aifaner: Aifaner (WeChat: ifanr), conteúdo mais interessante será trazido para você o mais rápido possível.