Qual é o chip futuro em que Apple, Qualcomm e Google estão apostando? Filosofia Difícil

Durante minha experiência com o Pixel 6 Pro, além de tirar fotos, raramente senti algo errado com o que o Google chamou de "o telefone Pixel mais inteligente" até uma manhã quando o alarme do meu telefone me acordou.

Diferente da operação de deslizar para fechar o alarme em um celular normal, o Pixel 6 Pro me pede para dizer "Soneca (mais uma pausa)" ou "Parar (parar)" para controlar o alarme, e quando digo "Parar "Cuidado, o alarme O celular que não parava de tocar estava mudo.

É um pequeno recurso trivial, mas me mantém de bom humor todas as manhãs que acordo com meu despertador.

Finalmente, não preciso mais forçar a sonolência a procurar meu celular, só preciso de uma frase para calar o celular com risco de vida.Esta é a primeira vez que sinto que o celular pode me "compreender".

O segredo de "entender as palavras das pessoas" está escondido no humilde TPU.

Computação de IA onipresente

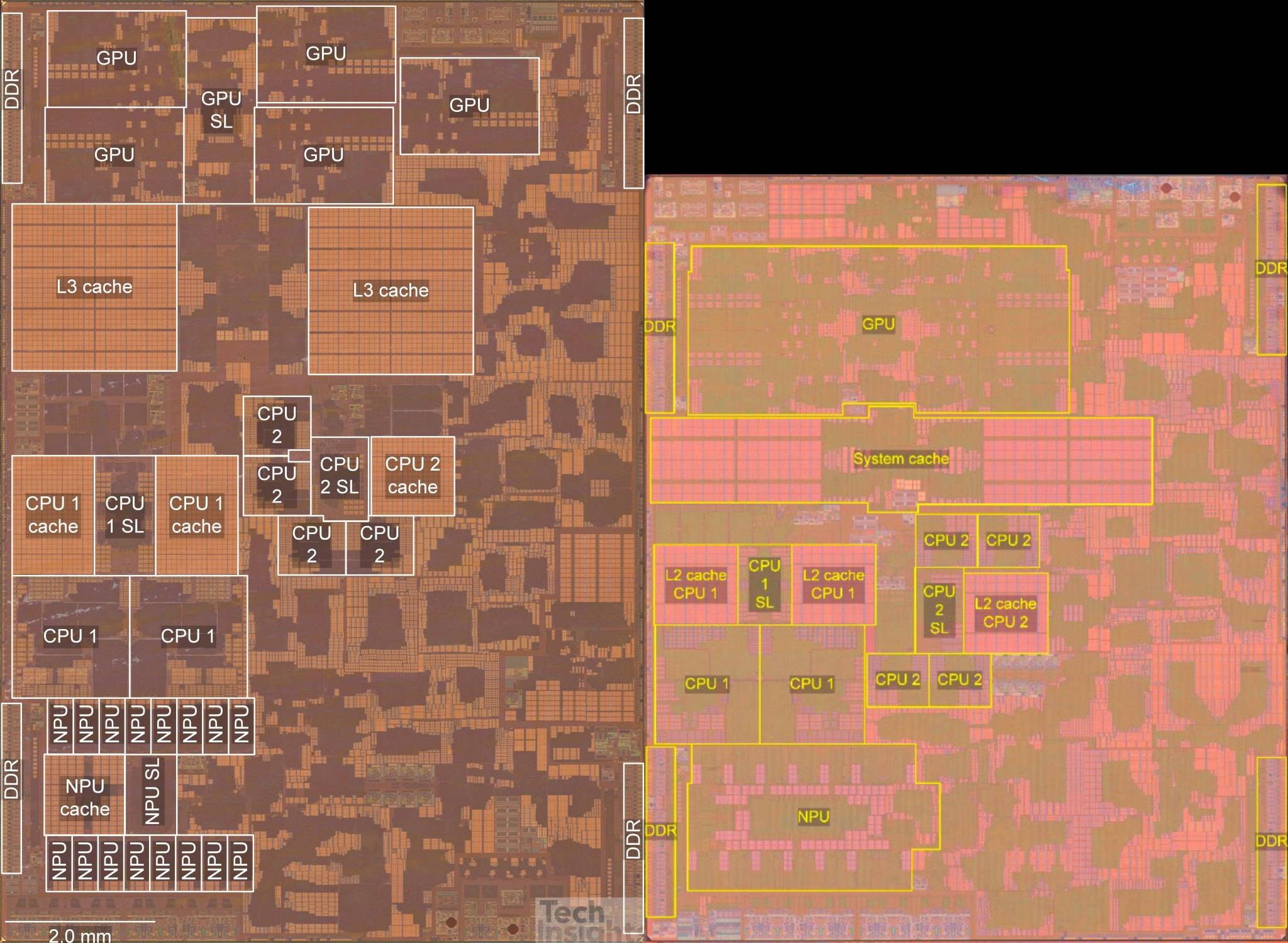

No SoC do celular, a presença do NPU é sempre mais fraca que a do CPU e GPU.

Esse processador que se concentra nas operações de rede neural nem tem um nome unificado: é chamado de NPU no chip Kirin e Neural Engine no chip biônico da série A; o Google o chama de TPU e a MediaTek acha que é usado para isso deve ser chamado de APU para cálculo de IA…

Embora esses chips tenham vários nomes e diferentes arquiteturas e princípios, seus propósitos são bastante semelhantes – acelerar o aprendizado de máquina e melhorar o poder de computação da inteligência artificial dos telefones celulares.

Se você prestar atenção ao desempenho do processador do celular, descobrirá que, seja o chip da série A do iPhone ou o chip Snapdragon do Android, o poder de computação da CPU foi aprimorado muito limitado no passado dois anos, e o fenômeno de "espremer pasta de dente" no desempenho é cada vez mais grave.

Em contraste, o poder de computação da IA tornou-se um indicador de parâmetro que mais fabricantes estão dispostos a mencionar. Tomando o chip da série A como exemplo, o chip biônico A14 da Apple quase dobrou seu poder de computação de pico em comparação com a geração anterior e pode realizar 11 trilhões de operações por segundo.

Um ano depois, o chip biônico A15 ainda pode trazer uma melhoria substancial de mais de 40% nessa base e pode realizar até 15,8 trilhões de operações por segundo.

O progresso do poder de computação de IA do campo Android também é muito impressionante. Na lista de testes de desempenho de IA lançada pela Universidade de Tecnologia de Zurique, a pontuação de desempenho do Kirin 970 AI, que foi introduzida pela primeira vez com NPU, marcou 23.600 pontos. Quatro anos depois, o chip Google Tensor alcançou o topo com uma pontuação alta de 214.700. , e Kirin 9000 e Snapdragon 888 também alcançaram cerca de 160.000 pontos.

Como o poder de computação da IA está crescendo quase exponencialmente, por que é difícil para nós sentir alguma mudança? A função da palavra AI, que soa um pouco avançada, está muito longe de nós?

▲ Imagem de: Gadgetmatch

Na verdade, toda vez que você desbloqueia o telefone, acorda o assistente de voz ou até mesmo pressiona o obturador, é um contato próximo com a computação de IA.

A NPU é como uma caixa preta, ela torna o processo de cálculo de IA quase inexistente, tornando você invisível para a tecnologia, mas cercado por uma interação humano-computador mais natural. A evolução do assistente de voz do Google é um bom exemplo.

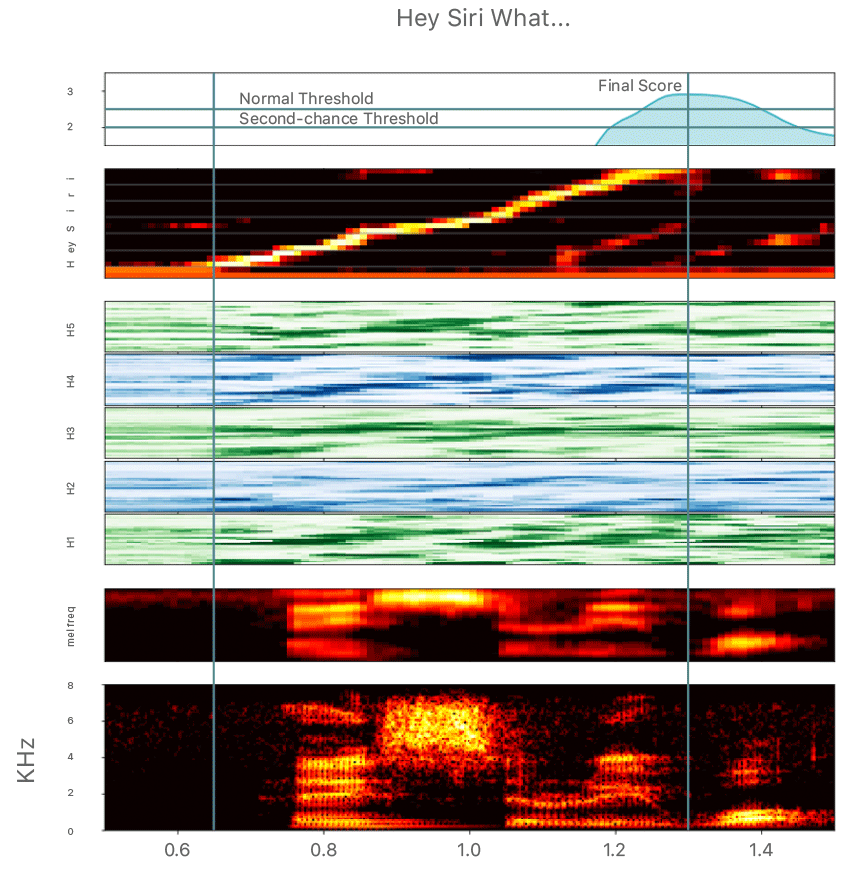

Desde que a Siri aderiu à função de ativação por voz de "Ei, Siri" em 2014, as palavras de ativação estão quase vinculadas ao assistente de voz. Toda vez que falamos com o assistente de voz, temos que nos dar ao trabalho de chamar seus nomes : Siri, Xiao Ai, Xiao Bu, Xiaoyi… Se o ambiente de voz for muito barulhento, esse processo embaraçoso pode ser repetido muitas vezes.

▲ A imagem de impressão de voz para reconhecer a palavra de ativação vem de: Apple

Isso ocorre porque, devido a considerações de consumo de energia, o processador do telefone móvel não pode desperdiçar energia de computação para analisar cada frase do usuário em segundo plano por um longo tempo. obrigados a trabalhar permanentemente.

Quando o sinal da palavra de ativação é recebido, o processador principal é mobilizado para ouvir a próxima instrução do usuário.

No entanto, embora isso possa atingir o despertar de voz de baixa potência, ainda está um pouco longe da forma ideal de assistentes de IA em filmes de ficção científica. É como o Homem de Ferro dizendo "Ei, Jarvis" antes de lutar. Novamente, humano- interação do computador é um pouco estranho.

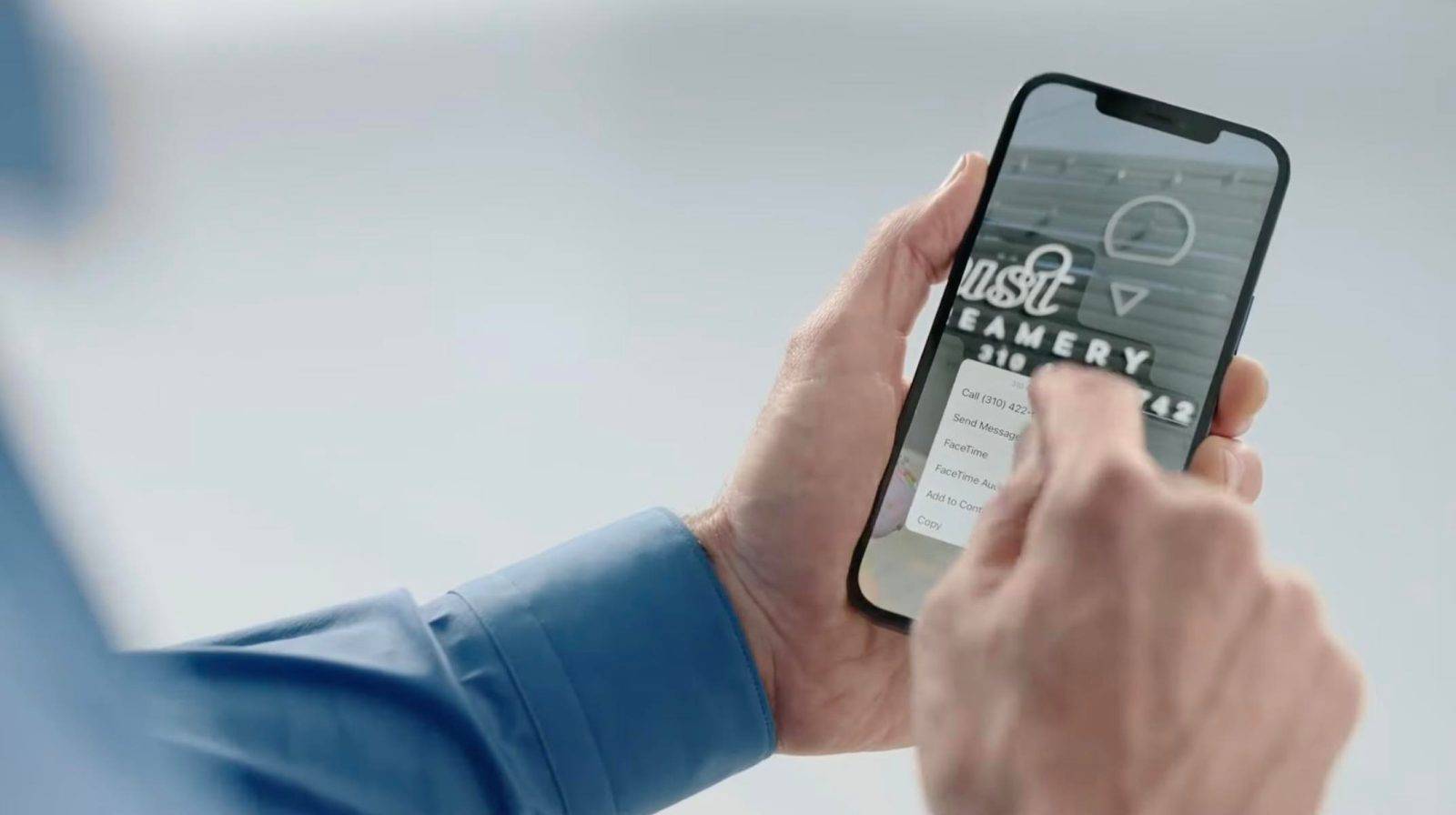

O recurso "Comandos de atalho" do Google na série Pixel 6 traz essa interação natural que existe em filmes de ficção científica para a realidade.

Conforme mencionado no início do artigo, os usuários também podem ativar o Google Assistant para executar tarefas específicas, como desligar o despertador e atender chamadas sem gritar palavras de ativação como "OK Google" por meio das "Instruções de atalho".

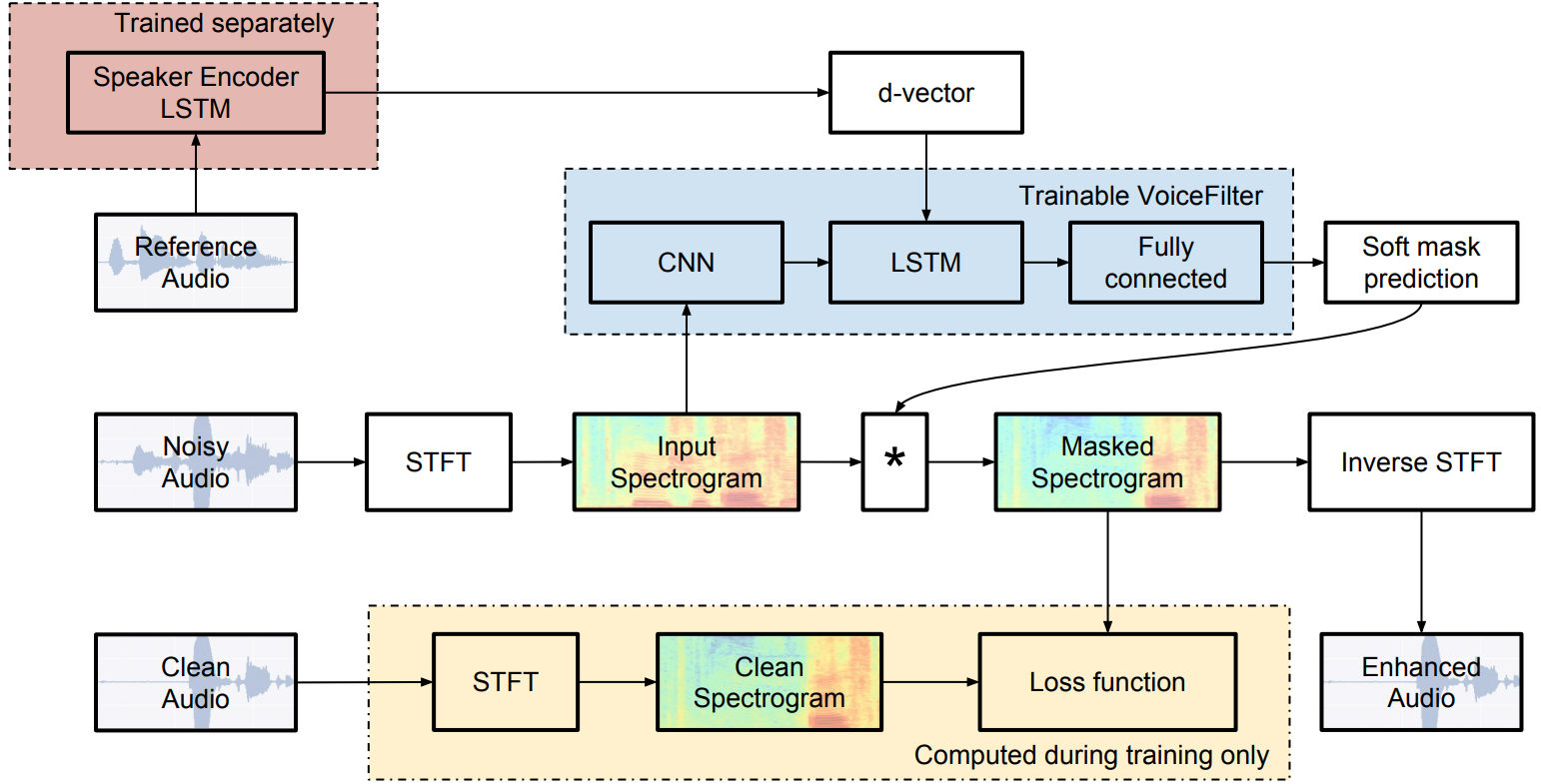

▲ Algoritmo VoiceFilter proposto pelo Google Image de: Google

Para separar direcionalmente as vozes humanas em um ambiente de som barulhento, os telefones celulares precisam ter recursos de reconhecimento de impressão de voz de alta precisão e usar algoritmos de rede neural convolucional mais complexos para capturar e reconhecer com precisão a senha do usuário.

E o chip TPU do Google especialmente projetado para computação de IA atende a essa demanda de poder de computação de IA, e essa interação de voz natural é finalmente realizada na série Pixel 6.

A NPU baseada na unidade de processamento neural é muito mais eficiente do que a CPU tradicional em reconhecimento e processamento de imagem e fala.Os fabricantes de telefones celulares podem, assim, desenvolver muitas funções, como fotografia computacional e reconhecimento de texto, para enriquecer as funções de software do sistema.

No iOS15 mais recente da Apple, muitos novos recursos são projetados com base em mecanismos de computação neural, como áudio espacial e modo retrato adicionados ao FaceTime, extração e tradução de texto em tempo real, álbuns de fotos para pesquisar diretamente texto em fotos, operação offline da Siri, etc. .

Como essas funções têm certos requisitos para o poder de computação da IA, a Apple também enfatizou que, se o chip SoC não for um modelo posterior do A12 Bionic, mesmo que você atualize para o iOS15, essas funções não poderão ser experimentadas.

Outro exemplo é a identificação inteligente de fotos de identificação no MIUI13, adicionando marcas d'água, proteção de privacidade de verificação facial e outras funções.Gestos espaciais e rotação de cabeça do HarmonyOS também são desenvolvidos usando tecnologias como reconhecimento de imagem AI e OCR de texto.

As funções de IA começaram a se tornar uma parte importante de nossa experiência diária com telefones celulares, e a NPU, que originalmente era considerada insignificante, tornou-se parte integrante da experiência do software do sistema.

Por que você precisa de chips de computação de IA?

Comparado com outras partes dos telefones celulares, o NPU apareceu muito mais tarde.

Em setembro de 2017, a Huawei lançou o Kirin 970 na exposição IFA em Berlim, que é o primeiro SoC com um NPU integrado. Durante o mesmo período, a Apple lançou o primeiro chip biônico A11 equipado com um mecanismo de computação neural. Os dois campos prestaram atenção para o campo da computação de IA de forma surpreendentemente síncrona.

O surgimento das funções de IA pode parecer abrupto, mas na verdade é o resultado da evolução natural durante o desenvolvimento das formas de smartphones.

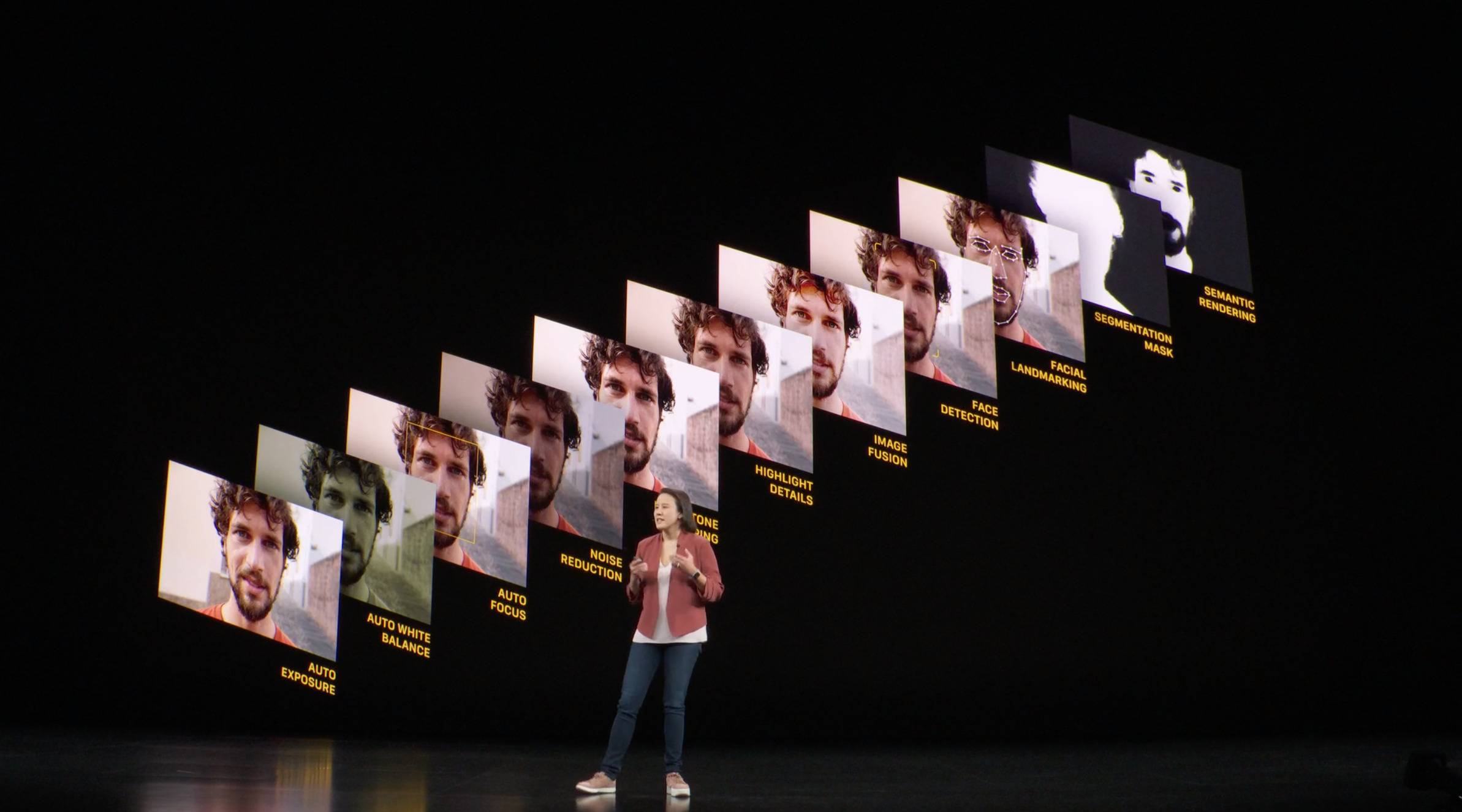

Em uma entrevista com o vice-presidente da Apple, Tim Millet, sobre os chips da série A, a revista Wired mencionou que alguns anos antes do lançamento do iPhone X, alguns engenheiros da Apple propuseram o uso de algoritmos de aprendizado de máquina para tornar a câmera do iPhone mais inteligente.

É essa ideia que torna possível o iPhone X, que define a forma do iPhone na próxima década. Mudar para o iPhone X em tela cheia requer um novo mecanismo de segurança para substituir o Touch ID que originalmente ocupa o queixo, e não pode ficar atrás do anterior em termos de precisão e velocidade de desbloqueio. reconhecimento.

Toda vez que o iPhone é ligado para desbloquear, a câmera com sensor de profundidade localizada na franja criará um mapa de profundidade através de milhares de pontos, que serão comparados com os dados de rosto armazenados para concluir o desbloqueio, e esse processo de coleta, criação e revisão precisa ser controlada.Em um piscar de olhos, mais importante, o consumo de energia deve ser mantido em um nível baixo o suficiente.

De acordo com dados divulgados pela Apple, os usuários do iPhone desbloqueiam em média 80 vezes por dia. Se a CPU ou GPU precisar ser mobilizada para realizar operações gráficas de alta potência toda vez que desbloquear, será um desafio considerável para a vida útil da bateria do o telefone.

▲ O processo de aprendizado de máquina

O mecanismo de computação neural de arquitetura multinúcleo pode realizar um grande número de operações ao mesmo tempo e, por meio de aprendizado de máquina profundo, pode reconhecer e julgar informações de rosto humano como o cérebro humano. desempenho do que CPUs tradicionais. pequena vantagem.

"Não poderíamos ter feito isso sem um mecanismo de computação neural", disse Tim Millet na entrevista.

Com o aumento do número de núcleos, o poder de computação do mecanismo de computação neural também será bastante aprimorado e suas aplicações se tornarão cada vez mais extensas.

Por exemplo, o mecanismo de computação neural de 8 núcleos do chip biônico A13 traz funções de Deep Fusion e modo de cena noturna para a série iPhone11, o que melhora a clareza e os detalhes das fotos por meio de várias fusões; Chame várias câmeras ao mesmo tempo para obter um experiência de zoom suave.

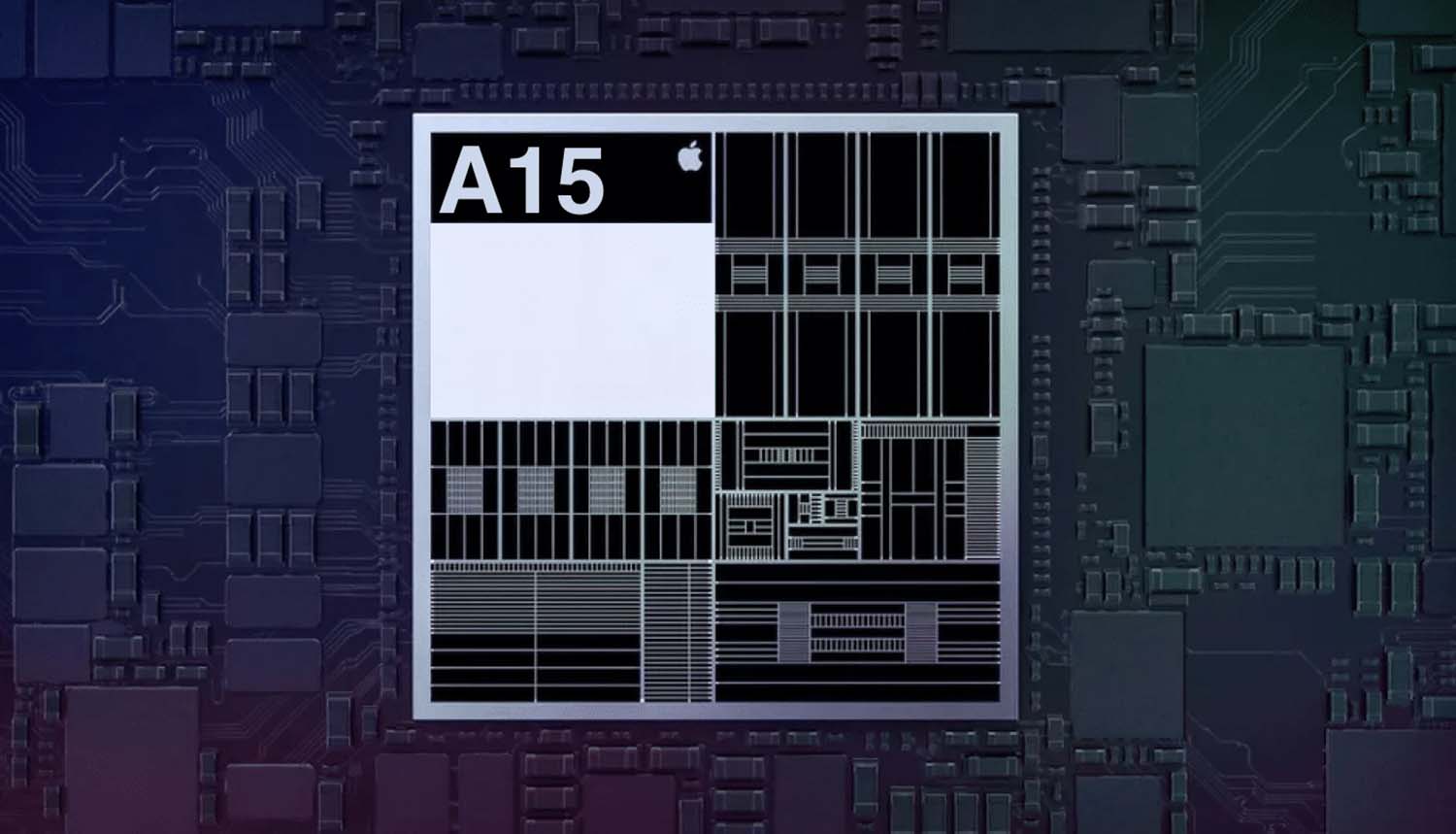

▲ Anatomia do chip biônico A15 e chip biônico A14, o mecanismo de computação neural está concentrado no canto inferior esquerdo

Em geral, o surgimento de NPUs, como mecanismos de computação neural, pode compartilhar a pressão de computação de CPU ou GPU. Por meio de análise paralela eficiente e cálculo de big data, resultados significativos podem ser extraídos e processamento mais natural pode ser usado. Capacidade de melhorar nossa experiência.

AI vai definir smartphones novamente

John Giannandrea, vice-presidente sênior de estratégia de aprendizado de máquina e inteligência artificial da Apple, mencionou em uma entrevista que acredita que nos próximos anos todas as funções do iOS ou do ecossistema de software da Apple serão alteradas pelo aprendizado de máquina.

Acho que a Apple sempre representou a interseção entre criatividade e tecnologia. Quando você pensa em construir experiências inteligentes, é muito importante integrar verticalmente apps, frameworks, chips… Acho que é uma jornada, esse é o futuro dos dispositivos de computação que temos, eles ficam inteligentes, e então essa Inteligência ficará invisível .

O iPhone original redefiniu o celular com interação touch screen e conexão com a Internet a qualquer hora, em qualquer lugar.Desde então, o celular surgiu como um ramo de "telefone funcional" e "telefone inteligente".

Quando as funções dos telefones inteligentes convergem, os chamados "inteligentes" – enviar WeChat, tocar música, tirar fotos, assistir notícias, etc., de certa forma, retornam às funções.

▲ Imagem de: Gadgetmatch

Os smartphones precisam ser redefinidos e a nova inteligência deve ser interpretada como um telefone celular que "entende as pessoas". Ele pode reconhecer o mundo que você vê, entender todos os seus comandos e se ajustar dinamicamente de acordo com o ambiente. Tudo isso requer chips de IA. Obtenha profundamente envolvido.

À medida que a cadeia de suprimentos de hardware para telefones celulares se torna cada vez mais transparente, as diferenças nos componentes principais dos telefones celulares de gama média a alta estão se tornando cada vez menores, e as funções de software têm recebido cada vez mais atenção dos fabricantes. , a cadeia de suprimentos de hardware fornece uma boa maneira de fazer um Os "ingredientes básicos" dos pratos, e se você quiser cozinhar um sabor único, excelente experiência de software é o "tempero" chave.

Hoje, já temos uma tela clara o suficiente e uma câmera que pode fotografar paisagens a 100 metros de distância, mas a experiência dos smartphones não se limita à exibição e fotografia convencionais.

![]()

Ele deve permitir que você tire várias fotos de distância focal ao mesmo tempo, para que você não perca o cenário correndo para focar; deve ser capaz de visualizar a cena noturna ou o efeito HDR em tempo real no visor, e não esperar mais pela imagem; deve até se tornar Um tradutor que pode acompanhá-lo em suas viagens, mesmo que a rede seja ruim, pode concluir o trabalho de tradução em tempo real offline.

A IA é a melhor escolha para nos ajudar a realizar essas funções. Para personalizar mais profundamente as funções do software, mais fabricantes de telefones celulares, como Google e OPPO, começaram a participar do design de chips NPU para acompanhar os precursores, como Apple e Huawei.

Ao mesmo tempo, o poderoso poder de computação de IA não é mais a patente de players de chips desenvolvidos por eles mesmos. O Qualcomm Snapdragon 8 e o Dimensity 9000 consideram o poder de computação de IA como o foco da melhoria e superaram o Tensor do Google em pontos de execução de desempenho de IA. O recém-lançado Exynos 2200 também se concentra em melhorar o desempenho da NPU, trazendo o dobro da melhoria.

Os esforços concentrados dos gigantes de chips no desempenho da IA fazem com que os chips móveis de IA pareçam estar experimentando a "nova Lei de Moore".

Além da velocidade de crescimento do desempenho, a popularidade dos chips de IA também é muito impressionante. De acordo com as estatísticas da agência de estatísticas Counterpoint, o número de telefones celulares com chips de IA integrados em 2017 representou apenas 3% do mercado share, e em 2020 esse número chegou a 35%.

No futuro, mais telefones celulares suportarão computação acelerada por IA, o que significa que o uso de aprendizado de máquina para desenvolver aplicativos móveis se tornará o novo normal. o aprendizado já apareceu. Realize funções de IA, como desfoque de fundo e recorte com um clique.

Com a participação de fabricantes de telefones celulares e desenvolvimento de terceiros, os aplicativos de IA continuarão a se aprofundar, e a forma dos smartphones também pode mudar de acordo, tornando-se uma simbiose software-hardware para uma experiência agradável.

Nesse momento, a batalha pelo direito de falar na forma de smartphones passará gradualmente da gestão da cadeia de suprimentos para o controle do big data do usuário.

#Bem-vindo a prestar atenção à conta oficial do WeChat de Aifaner: Aifaner (WeChat: ifanr), mais conteúdo interessante será trazido para você o mais rápido possível.