Tirando fotos e batendo papo, por que alguém pensa que vou cometer um crime?

Trabalhos de cinema e televisão como "Minority Report" e "Suspect Tracking" podem aparecer apenas nos últimos anos. Se for um filme e um trabalho para televisão nos últimos anos, o público ficará muito "atrapalhado".

Prevenção do crime, modelos preditivos, usam o sistema para especular sobre o que não aconteceu … Isso significa que muitas informações serão coletadas e também significa que você será julgado por um sistema desconhecido se há uma ameaça. A sensação de confiar o destino ao desconhecido, provavelmente muitas pessoas não gostam.

Mas pode não haver como não gostar, porque antes que você perceba, cada vez mais empresas já estão coletando suas informações públicas para julgar a possibilidade de seu crime a partir do conteúdo diário de sua rede social.

▲ Foto de: "Minority Report"

A mídia social se tornou o maior denunciante. Isso é uma autorrelato?

Voyager, Kaseware, Aura, PredPol, Palantir, que são algumas empresas que procuram identificar potenciais ameaças através das redes sociais, grande parte delas também coopera com a polícia local e está na vanguarda da prevenção do crime.

A obtenção das informações exigidas nas redes sociais de todos é o cerne desse tipo de empresa, que utiliza o conteúdo postado pelos usuários nas redes sociais para estimar se a outra parte tem probabilidade de cometer um crime. Os algoritmos dessas empresas não são os mesmos, mas basicamente usam inteligência artificial para decifrar a fala do usuário, julgando pelo conteúdo compartilhado pelo usuário se o sujeito cometeu um crime, pode cometer um crime ou aderir a um determinado perigo ideologia.

▲ Página oficial do site Kaseware

Na verdade, não se trata de um empreendimento novo. Afinal, em 2012, algumas pessoas transformaram as redes sociais no "pulso da cidade". É difícil ver um espaço e um produto que possa acomodar tantos usuários ao mesmo tempo e torná-los dispostos a compartilhar tudo sobre si mesmos.

As características das redes sociais criam condições para que as pessoas encontrem objetivos. Os alunos procuram entrevistados nas redes sociais, as agências de estatística preveem resultados eleitorais nas redes sociais e os detetives de IA querem encontrar criminosos nas redes sociais.

Como todos usam redes sociais, as redes sociais geralmente podem refletir a situação real de uma pessoa. O deputado Tyrone Carter, do estado de Michigan, nos Estados Unidos, acredita que a busca da polícia nas redes sociais públicas não violou nenhuma lei e não infringiu os direitos dos usuários, portanto essa previsão é viável.

No momento em que você clica em enviar na página pública, a postagem não é mais sua. As pessoas têm problemas por causa do que postam, porque a mídia social é o maior "autoinformador" que já vi.

▲ Foto de: Lifehacker

Mas o segredo só será revelado quando for guiado. A Voyager Labs, que cooperou com o Departamento de Polícia de Los Angeles, desempenhou o papel de líder neste processo. Somente a organização sem fins lucrativos Brennan Center descobriu, por meio de informações públicas fornecidas pelo Departamento de Polícia de Los Angeles, que o trabalho da Voyager também era suspeito de discriminação racial e violação de privacidade.

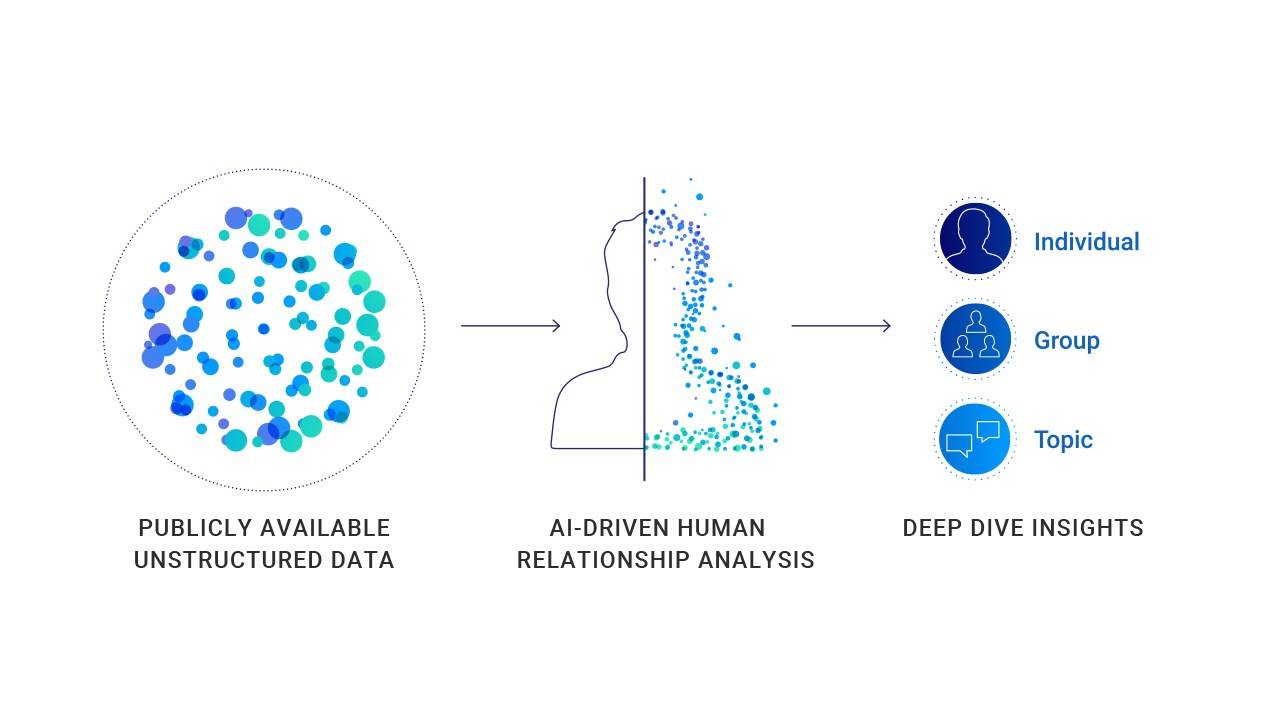

A maneira como empresas como a Voyager trabalham não é complicada. Ele coleta todas as informações públicas nas redes sociais de uma pessoa, incluindo postagens, contatos e até mesmo emojis comumente usados. Em alguns casos especiais, ele usará as informações públicas e as não públicas para fazer referência cruzada para análise e indexação posteriores.

▲ A Voyager fará julgamentos com base em tópicos pessoais de participação na mídia social

Por meio do serviço da Voyager, a polícia pode ver claramente as relações sociais de uma pessoa. Como estão suas conexões e como interagem nas plataformas sociais. Além disso, a Voyager pode até detectar se há uma conexão indireta entre dois usuários (ambos têm pelo menos quatro amigos idênticos).

Parece que é apenas ver o que os usuários fazem nas redes sociais, que é usado como informação complementar para pesquisas. Mas, na verdade, a Voyager não apenas coleta e exibe informações, mas também faz julgamentos.

▲ A Voyager fará julgamentos e previsões por meio da cadeia de relacionamento da rede social

A Voyager mencionou um caso de agressão em um documento enviado ao Departamento de Polícia de Los Angeles. O caso demonstrou especificamente a abordagem da plataforma – a IA analisará automaticamente o conteúdo das postagens das pessoas nas redes sociais sem intervenção humana. E a classificação (respectivamente, marcar o usuário em três cores de azul, laranja e vermelho).

Em um caso específico, Adam Alsahli, o suspeito do tiroteio, foi julgado pelo sistema como “um forte senso de orgulho e identificação com as tradições árabes” por causa de suas fotos com tema islâmico postadas no Facebook e Instagram. Portanto, Adam Alsahli foi marcado em laranja pela ferramenta de inteligência artificial da Voyager antes de lançar um ataque específico.

Este pode ser um caso de previsão bem-sucedida de criminosos em potencial, mas também um caso cheio de "preconceitos".

▲ As informações de mídia social de Adam Alsahli, o suspeito do crime, foram marcadas em laranja antes de ele cometer o crime

Os dados prevêem o crime? Mas os dados não podem ser totalmente acreditados

Essas conclusões são realmente confiáveis? Com base em que eles fazem julgamentos? Como todos podem provar sua inocência com big data?

De fato, existem muitos dados que confirmam a correlação entre o viés de conteúdo das redes sociais e os fatos do crime, mas não se trata de um dado de correlação de 100%.

A Escola de Engenharia Tandon da Universidade de Nova York e a Escola de Saúde Global e Saúde Pública divulgaram resultados de pesquisas que mostram que cidades com mais discurso de ódio racial no Twitter têm taxas de criminalidade mais altas; estudos na Finlândia também mostram que, com base em duas décadas de dados, a cada 1 ° C de aumento na temperatura, a atividade criminosa aumentará 1,7%; estudos americanos mostraram que a taxa de roubo de veículos nas noites de fim de semana aumenta drasticamente; e foi provado que quando o time de futebol local perde acidentalmente, os incidentes de violência doméstica aumentar em 10%.

▲ AI não pode tomar decisões com 100% de precisão

Mas isso não pode provar nada, porque probabilidade e fato são diferentes.

Mesmo com o endosso de dados relevantes, não é possível comprovar que nas cidades com maior discurso de ódio racial os veículos devem ser roubados nos fins de semana de verão. No clima quente, quando o time da casa perde 100%, mais casos de violência doméstica ocorrerão.

Sistemas semelhantes de previsão de crimes são revertidos com base em fatos existentes sobre crimes e resultados de pesquisas.Outro problema que isso cria é que está cheio de "estereótipos".

O vencedor do Prêmio Turing, Yang Likun, disse certa vez que, quando os dados são tendenciosos, os sistemas de aprendizado de máquina tornam-se tendenciosos. Em um único caso, quando a informação recebida pelo aprendizado de máquina é que usuários negros na prisão representam uma grande proporção, tal sistema pode fazer um julgamento de que homens negros são mais propensos a cometer crimes.

▲ Yang Likun disse que o preconceito dos sistemas de aprendizado de máquina vem das pessoas

Para o aprendizado de máquina, "homens negros são mais propensos a cometer crimes" pode ser um fato de análise de dados, mas na realidade será preconceito racial e tratamento diferenciado.

Classificar usuários secretamente, dividir quais são mais ameaçadores e rastrear e prevenir aqueles que são ameaçados mais de perto são a lógica operacional de todo o sistema.

Startups semelhantes usarão algoritmos e inteligência artificial para explicar o processo que processam e analisar informações para tomar decisões. Embora atualmente não haja evidências que comprovem que essa previsão seja eficaz e haja muitas dúvidas do público, a polícia ainda quer cooperar com plataformas semelhantes.

▲ Para a polícia, o serviço de previsão da plataforma é muito valioso

Para a polícia, esse tipo de ferramenta é muito atraente, pois a descoberta de plataformas como o Voyager nas redes sociais pode ajudar de forma eficaz a criação de perfis de usuários, sem perder as sutis pistas online. Se for apenas uma investigação auxiliar, esta será uma ferramenta muito eficaz. No entanto, quando a ferramenta evolui para o estágio posterior e começa a desempenhar um papel na previsão do crime, ela também se tornará uma arma para ferir.

Após o entusiasmo dos anos anteriores de financiamento, muitos produtos de IA entraram na fase de aplicação. Mas em algumas áreas, eles ainda desempenham o papel de auxiliares.

O atendimento médico é um campo que é cauteloso quanto à intervenção em IA. Mesmo no campo de imagens médicas de IA mais rápido e avançado, a tecnologia de IA de hoje ainda não pode garantir 100% de precisão e requer a intervenção de médicos humanos. Porque todos sabem que a assistência médica é um setor que exige quase 100% de precisão, qualquer desvio ou erro pode causar sérias consequências.

▲ Nesta fase, podemos precisar de mais policiais humanos

O campo do policiamento também é um campo que se esforça para estar 100% correto, e qualquer conjectura e inferência também pode causar graves consequências sem o apoio de evidências. Uma pessoa que publica vários comentários discriminatórios e violentos nas redes sociais pode ser marcada como um potencial perpetrador. Há 90% de possibilidade de cometer um crime violento, mas antes de cometer um crime, é uma pessoa normal.

No conjunto de dados geral, nunca podemos ignorar que todos são indivíduos independentes.

#Bem-vindo a seguir a conta oficial do WeChat da Aifaner: Aifaner (WeChat ID: ifanr), mais conteúdo interessante será fornecido a você o mais rápido possível.