01Wang lançou o modelo de 100 bilhões de parâmetros Yi-Large, Kai-fu Lee: os grandes modelos da China alcançaram os Estados Unidos e estão determinados a rivalizar com o GPT-5

Depois de um ano, Kai-Fu Lee saiu do círculo novamente com "Zero One Thousand Things".

Em maio do ano passado, a Zero One Thing foi criada e seis meses depois lançou seu primeiro modelo bilíngue chinês-inglês da série Yi. Desde o início, Kai-Fu Lee estabeleceu uma meta ambiciosa e difícil: "tornar-se o número 1 do mundo".

Lingyiwuwu, que é uma “galinha quente popular” desde o nascimento, também contou com uma equipe com experiência em uma grande empresa e excelente desempenho de modelo para atingir uma avaliação de US$ 1 bilhão.

Hoje, eles estão trazendo seu segundo produto: o modelo de código fechado Yi-Large .

Ataque o modelo SOTA global

Em novembro do ano passado, o Yi-34B lançado pela Lingyiwuwu foi classificado na lista Hugging Face com seu tamanho "nível sobremesa" na comunidade de código aberto, superando modelos várias vezes maiores, como Llama2-70B e Falcon-180B, e se tornou o o maior modelo do mundo na época. Um dos modelos básicos mais fortes de código aberto interno.

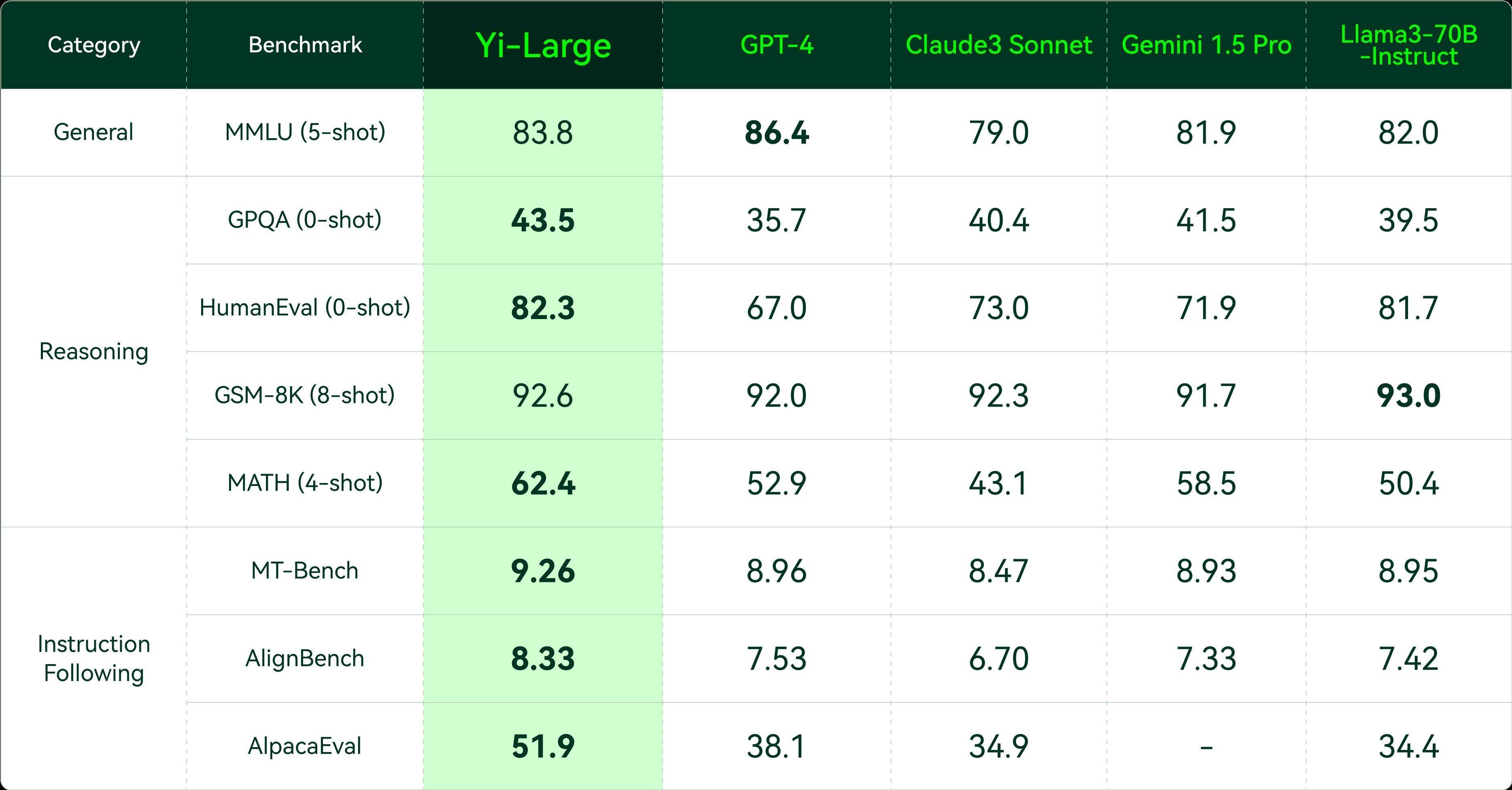

Meio ano depois, 01Wang lançou oficialmente o Yi-Large com uma escala de parâmetros de 100 bilhões. Na avaliação oficial de terceiros, o modelo 01Wanyi Yi teve um bom desempenho no PK bilíngue em chinês e inglês dos principais modelos de grande porte do mundo.

Nas últimas classificações de modelos oficialmente certificados da AlpacaEval 2.0, uma agência de avaliação de Stanford, o principal indicador de proficiência em inglês do modelo Yi-Large, LC Win Rate (controlando o comprimento da resposta), ocupa o segundo lugar no mundo, perdendo apenas para o GPT -4 Turbo, Win Rate ainda ocupa o primeiro lugar no mundo.

Anteriormente, apenas Yi e Qwen entre os modelos nacionais estavam entre os 20 primeiros desta lista.

Um pré-requisito importante para usar um modelo grande de maneira inteligente é que ele saiba do que você está falando.

Os modelos estrangeiros têm excelente desempenho, mas todos são baseados no contexto inglês. No entanto, os grandes modelos nacionais nascidos no país apresentam vantagens únicas na compreensão do chinês.

Em termos de habilidade no idioma chinês, no desempenho de benchmark de abril atualizado pelo SuperCLUE, Yi-Large também ficou em primeiro lugar entre os grandes modelos nacionais. As habilidades bilíngues abrangentes de chinês e inglês da Yi-Large demonstraram excelente desempenho.

Em uma avaliação de capacidade mais abrangente de modelos grandes, Yi-Large superou modelos semelhantes como GPT4, Claude3 e Google Gemini 1.5 na maioria dos indicadores, alcançando o primeiro lugar. Alcançou melhores resultados do que os líderes globais em habilidades gerais, geração de código, raciocínio matemático e seguimento de instruções, e classificou-se firmemente entre os primeiros escalões do mundo.

À medida que as capacidades dos grandes modelos de cada empresa entram numa nova fase de esforço para comparar com o GPT4, o foco da avaliação dos grandes modelos também começou a mudar de capacidades gerais simples para capacidades de raciocínio complexas, como matemática e codificação.

Yi-Large também obteve resultados impressionantes em conjuntos de avaliação como HumanEval para capacidades de geração de código, GSM-8K e MATH para capacidades de raciocínio matemático e GPQA para capacidades especializadas de domínio.

Além disso, do ponto de vista da implementação da indústria, a compreensão das instruções humanas e o alinhamento das preferências humanas tornaram-se capacidades indispensáveis para grandes modelos, e as avaliações relacionadas ao seguimento de instruções (Instruction Following) são cada vez mais valorizadas pelas grandes empresas globais de modelos.

MT-bench lançado pelo projeto de avaliação de código aberto de Stanford AlpacaEval e Berkeley LM-SYS são dois conjuntos de conjuntos de avaliação de conformidade de instruções em inglês, e AlignBench é um benchmark de avaliação de alinhamento chinês lançado pela equipe da Universidade de Tsinghua.

No conjunto de avaliação de instruções oficiais no país e no exterior, o Yi-Large teve um desempenho melhor do que os cinco principais modelos internacionais.

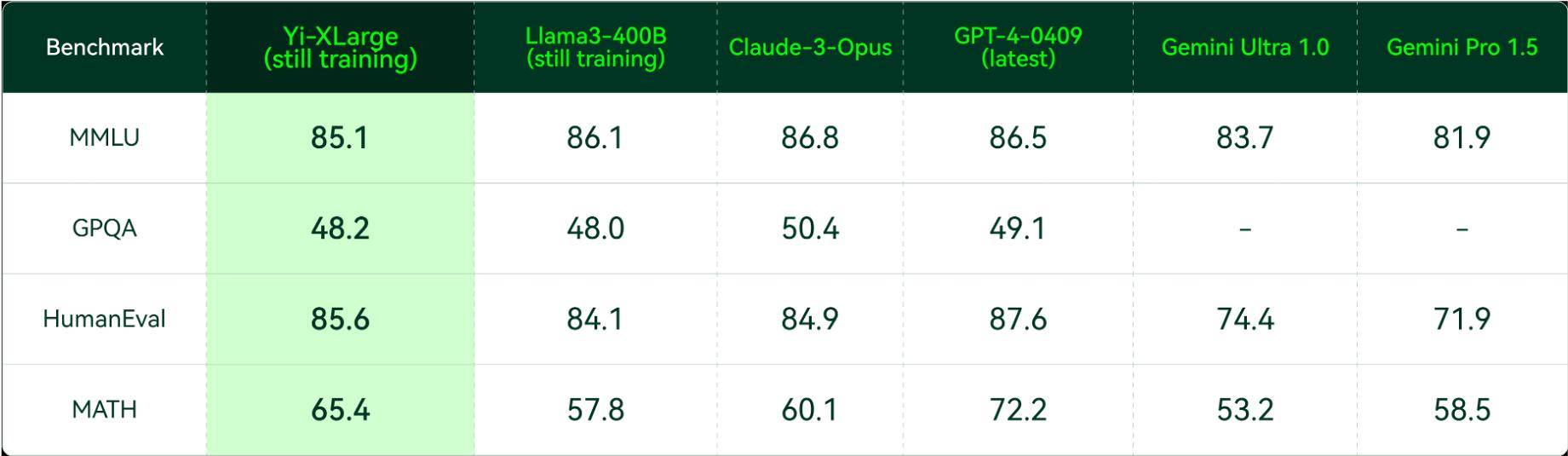

Na conferência de imprensa, Kai-fu Lee também anunciou que Zero One Wish lançou o treinamento do modelo Yi-XLarge MoE de próxima geração, que impactará o desempenho e a inovação do GPT-5.

Ao mesmo tempo, Zero Mil Coisas também está considerando algumas questões muito complexas. Kaifu Lee resumiu três pontos principais:

- Por um lado, precisamos de nos preparar para o avanço da tecnologia e para que tipo de modelos podemos produzir;

- Em segundo lugar, como minimizar o custo do raciocínio e deixar-nos acender o ponto da inclusão;

- Terceiro, existe o PMF tradicional para encontrar as necessidades do usuário.

Kai-Fu Lee disse que essas considerações são algo que geralmente não veem nas empresas do Vale do Silício:

Esta é a nossa abordagem única e uma oportunidade para os unicórnios chineses.

Yi-1.5 foi totalmente atualizado e a plataforma API foi lançada globalmente.

Nesta conferência de imprensa, a série Yi de modelos de código aberto também recebeu uma atualização abrangente. O Yi-1.5 é dividido em três versões: 34B, 9B e 6B, e o modelo de ajuste fino Yi-1.5-Chat é fornecido para os desenvolvedores. escolha.

A julgar pelos dados de avaliação, a série Yi-1.5 continua o excelente desempenho dos modelos de código aberto da série Yi. Embora a lógica matemática e os recursos de codificação sejam amplamente aprimorados, os recursos de linguagem também mantêm o alto nível original.

Após o ajuste fino, o Yi-1.5-6B/9B/34B-Chat melhorou para um nível mais alto em termos de raciocínio matemático, capacidade de codificação e seguimento de instruções.

O desempenho do Yi-1.5-6B/9B-Chat em conjuntos de avaliação de habilidades matemáticas, como GSM-8K e MATH, e conjuntos de avaliação de habilidades de código, como HumanEval e MBPP, está longe de ser o mesmo do modelo de nível de parâmetro, e também é melhor do que o recentemente lançado Llama-3-8B -Instruct.

As pontuações no MT-Bench, AlignBench e AlpacaEval também estão na posição de liderança entre os modelos com a mesma magnitude de parâmetro.

No ano passado, Zero One Wanwan optou por lançar o modelo da série Yi como código aberto, e seu excelente desempenho foi altamente reconhecido por desenvolvedores internacionais.

No primeiro mês após o lançamento da versão de código aberto Yi em novembro de 2023, ele ocupou quase 50% das classificações de modelos populares na comunidade de código aberto. Um mês após seu lançamento, o Yi-34B foi incluído no grande playground de modelos da Nvidia.

Kai-fu Lee também tem suas próprias ideias para solução de problemas quando se trata de questões como o desenvolvimento de grandes modelos e a implementação de produtos.

Em entrevista à APPSO, Kai-fu Lee disse:

Acreditamos pragmáticamente na AGI. Devemos usar o menor número de chips e o menor custo para treinar o melhor modelo possível. Ao mesmo tempo, continuaremos a explorar e encontrar o TC-PMF. Em comparação com as empresas do Vale do Silício, a diferença entre as empresas start-up nacionais é que podemos olhar para as estrelas, mas também podemos manter os pés no chão.

A única ideia de que nem todas as coisas produzirão milagres com pura força é perguntar se pode usar dez bilhões de dólares ou cem bilhões de dólares. OPEN AI está qualificado para tentar esse caminho, mas não é esse o caminho que eles querem seguir. É claro que eles não perderão tempo para prever o ponto de ignição do AGI, mas ele pode dizer a todos com certeza o que é mais relevante. deles é o ponto AI Pratt & Whitney.

Hoje, Lingyiwanwu também anunciou que lançou vários modelos de interfaces API, incluindo Yi-Large, Yi-Large-Turbo, Yi-Medium, Yi-Medium-200K, Yi-Vision, Yi-Spark, etc. vez, o site Yi API Platform em inglês está aberto a desenvolvedores de todo o mundo para aplicativos de teste simultaneamente.

Entre eles, a API Yi-Large com escala de parâmetros de 100 bilhões tem geração de supertexto e desempenho de raciocínio, e é adequada para raciocínio complexo, previsão, criação de conteúdo aprofundado e outros cenários;

A API Yi-Large-Turbo é balanceada e ajustada com alta precisão com base no desempenho, velocidade de inferência e custo, e é adequada para todos os cenários, inferência de alta qualidade e geração de texto.

A vantagem da API Yi-Medium está na capacidade de seguir instruções, o que é adequado para chat, diálogo, tradução e outros cenários em cenários regulares;

Se precisar de aplicativos relacionados a documentos de conteúdo ultralongo, você também pode escolher a API Yi-Medium-200K, que pode interpretar 200.000 palavras de texto por vez;

A API Yi-Vision possui recursos de compreensão e análise de imagens de alto desempenho e pode servir bate-papo baseado em imagens, análises e outros cenários;

A API Yi-Spark concentra-se em respostas leves e extremamente rápidas e é adequada para análises matemáticas leves, geração de código, chat de texto e outros cenários.

Mais importante ainda, já existem aplicações práticas, e o “Pequeno Pâncreas” desenvolvido para pacientes com tumores pancreáticos é uma delas.

O assistente Xiaoyibao AI pode apresentar conhecimento abrangente de tratamento aos pacientes 24 horas por dia, 7 dias por semana.

O suporte técnico por trás deste assistente é o modelo Yi do Zero One Thing. Depois de usar a API Yi para chamar o grande modelo de IA, Xiaoweibao rompe a barreira de informação do tratamento do tumor pancreático e pode apresentar de forma precisa e sistemática o roteiro de tratamento do câncer pancreático e o plano de tratamento para pacientes com tumor pancreático.

Atualmente, este projeto de caridade ajudou mais de 3.000 pacientes com tumor pancreático.

Plataforma de trabalho completa

A conferência de imprensa de hoje também apresentou "Wanzhi", uma estação de trabalho completa de IA lançada recentemente pela Zero One Wagon.

De acordo com a introdução oficial, Wanzhi é uma plataforma de trabalho de IA completa especialmente projetada para usuários chineses. Ela pode fazer atas de reuniões, relatórios semanais, assistentes de redação, interpretar relatórios financeiros, documentos e fazer PPT. e é totalmente gratuito.

Atualmente, os usuários podem fazer login para experimentá-lo através do site oficial e do miniaplicativo WeChat "Wanzhi AI".

Na conferência de imprensa, os responsáveis de Wanzhi deram um exemplo muito prático:

Você acabou de chegar na empresa e de repente seu líder lhe pediu para fazer uma apresentação na reunião, mas o computador não está por perto. Agora, através do Wanzhi, digite o tema que deseja apresentar no seu celular e aguarde os dois. minutos que você leva para ir do elevador até sua estação de trabalho. Isso foi feito na página da Wanzhi. Depois disso, você só precisa fazer alguns textos simples, imagens e modificações para usá-lo diretamente.

Além disso, Wanzhi tem muitas outras funções.

A primeira é a capacidade de leitura de documentos. O Wanzhi AI Assistant pode ler e compreender rapidamente uma grande quantidade de conteúdo de documentos, incluindo documentos longos e dados financeiros complexos. Ele pode extrair informações importantes em poucos segundos e oferece suporte à leitura bilíngue em chinês e inglês.

Em segundo lugar, em cenários gerais de perguntas e respostas, Wanzhi também demonstrou excelente desempenho do produto, sendo capaz de dar respostas adequadas rapidamente e fornecer feedback profissional e rápido.

Além disso, o Wanzhi AI Assistant não apenas oferece suporte à saída de texto, mas também pode exibir informações em vários formatos, como tabelas, fórmulas, códigos, etc., tornando os relatórios de trabalho e o planejamento de vida mais claros.

Finalmente, o Wanzhi AI Assistant pode acessar informações da Internet em tempo real, garantindo que os dados e insights obtidos pelos usuários sejam os mais recentes e precisos.

De acordo com a pesquisa e observação da equipe Wanzhi, a eficiência do trabalho pessoal aumentou em média mais de 50% após o uso do Wanzhi, especialmente em termos de recuperação de conhecimento, concepção e redação de documentos, etc., o que economiza um tempo significativo.

Atualmente, o Wanzhi AI Assistant é totalmente gratuito e aberto aos usuários.

Autoridades de Wanzhi disseram que a aplicação de grandes modelos semelhantes certamente se tornará um importante ponto de aterrissagem na China este ano.

Kai-Fu Lee também mencionou que este ano será o primeiro ano de ferramentas de produtividade de IA, porque alguns campos irão explodir este ano.

Ele acha que o valor real do AI-Frist é quem construirá um AI Douyin, AI WeChat e AI Taobao? Zero One espera que eles tenham potencial para servir como um acendedor.

No entanto, o ponto inclusivo de toda a IA não ocorrerá ao mesmo tempo e os requisitos de aplicação em alguns campos serão muito elevados.

Por exemplo, com as ferramentas de produtividade que estamos a criar agora, o utilizador é o responsável final pelo conteúdo produzido pela ferramenta de produtividade. Portanto, se houver alguns erros nele que não sejam perfeitos, precisem de ajustes finos ou mesmo de alguma pequena ilusão, é o usuário quem finalmente decide se pode ser modificado, então o indicador do usuário é se posso produzir um conteúdo melhor. em um tempo mais rápido do que sem esta ferramenta.

Kai-Fu Lee disse que o TC-PMF realmente conseguiu isso, mas pode ser melhor, então com certeza acontecerá nas ferramentas de produtividade este ano.

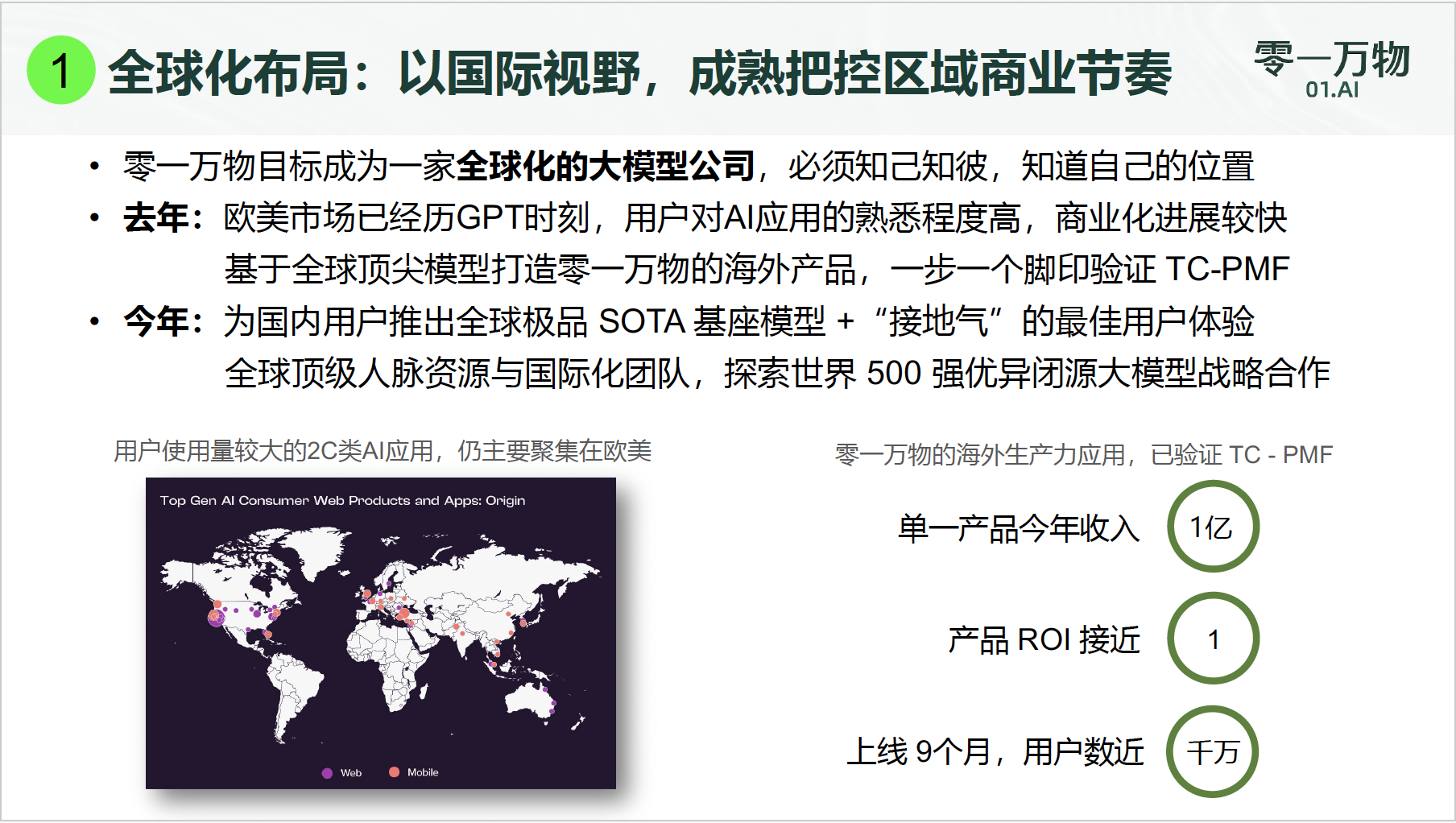

Atualmente, o número total de usuários estrangeiros de aplicativos de produtividade do Zero Mil Coisas está próximo de 10 milhões, e a receita de um único produto ToC este ano atingiu 100 milhões de yuans.

Kai-Fu Lee revelou:

Nosso ROI ainda está em torno de 1. Portanto, tais resultados são muito vantajosos, pelo menos na perspectiva das grandes empresas modelo nacionais.

No início de 2023, quando o campo de grandes modelos domésticos está em conflito, várias listas de avaliação são esmagadoras e não são poucos os modelos que estão no topo de cada lista principal.

Na era da IA 1.0, a inteligência artificial ainda não demonstrou altas capacidades de generalização e emergência, e o modelo de implantação privatizado para clientes principais tornou-se popular. No entanto, o tempo provou que a receita trazida pelo modelo de entrega pesada orientado a projetos existe. é um limite máximo para o crescimento e os seus desafios de sustentabilidade são graves.

Hoje estamos na era da IA 2.0 e a inteligência artificial entrou em um novo estágio de desenvolvimento. Em comparação com a versão 1.0, a IA 2.0 marca um salto do processamento automatizado baseado em regras para o aprendizado profundo e capacidades de aprendizagem autônoma.

Deste ponto de vista, a “Batalha dos Cem Regimentos” no campo da IA só se intensificará.

Desde o ano passado, cada vez mais modelos grandes produzidos internamente têm se destacado da acirrada concorrência e também alcançado resultados impressionantes em listas globais bem conhecidas.

Este ano, a indústria entrará em um estágio de implementação comercial mais realista e os usuários votarão com base nas capacidades demonstradas no lado do aplicativo. Como melhorar o efeito do aplicativo tanto quanto possível com base nas capacidades do modelo básico é uma questão importante para alcançar o TC-PMF.

Kai Fu Lee disse:

Há um ano, os grandes modelos da China sentiam-se demasiado atrasados (em relação aos Estados Unidos). Mas hoje temos muito orgulho de dizer que estamos correndo soltos há um ano e em termos de modelos, pelo menos alcançamos os principais produtos (modelos grandes) dos Estados Unidos que foram lançados há um ano, é claro. , continuaremos a trabalhar duro no futuro. No entanto, precisamos de precipitação e perspectivas para o futuro, e não podemos simplesmente correr como loucos.

Na era da IA, onde as ondas atrás do rio Yangtze empurram as ondas adiante, o maior significado para os usuários é conhecer a IA, entender a IA, usar a IA e até mesmo trazê-la para o trabalho, o estudo e a vida na competição entre os fabricantes.

E esta é também a intenção e o destino originais da tecnologia de IA.

*Fu Liqun também contribuiu para este artigo

# Bem-vindo a seguir a conta pública oficial do WeChat do aifaner: aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.