apenas! CEO da Deepmind ganha Prêmio Nobel de Química em 2024 Ao falar sobre IA, ele disse: Há exageros, mas ainda é subvalorizado.

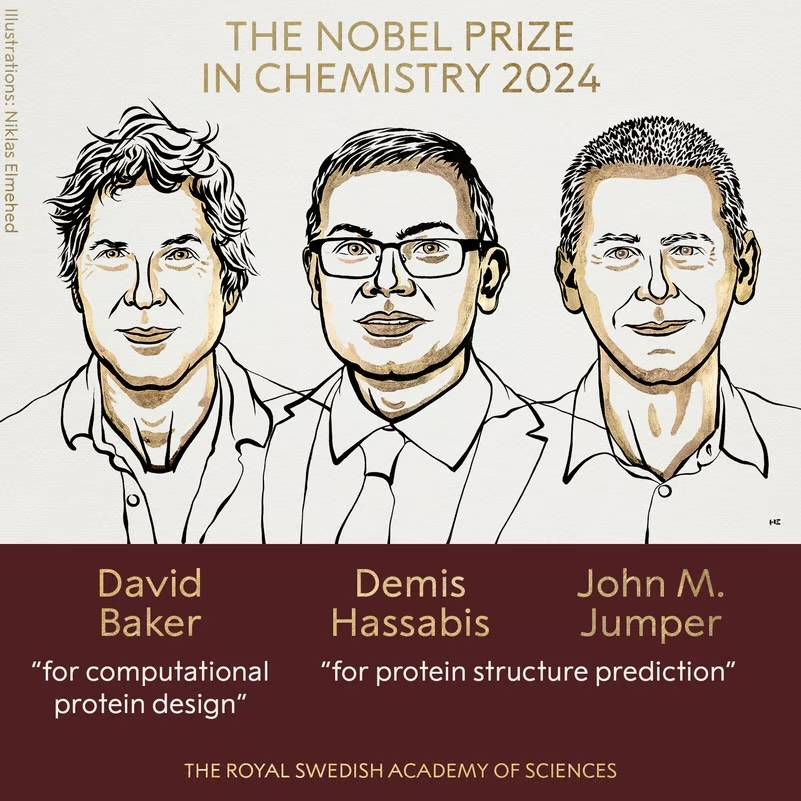

O Prêmio Nobel deste ano será ganho pela IA.

O recém-lançado Prêmio Nobel de Química foi ganho conjuntamente por David Baker, John M. Jumper e Demis Hassabis. O sobrenome deve ser familiar a todos, é o fundador da Deepmind.

Não muito tempo atrás, Demis Hassabis foi convidado no canal de podcast da DeepMind. Diante de Hannah Fry (a nova diretora do Instituto de Matemática Aplicada da Sociedade Britânica de Matemática), ele não apenas explicou a pesquisa da equipe sobre a estrutura das proteínas, mas também abordou. profundidade sobre o trabalho da DeepMind, Gemini e o que está por vir para AGI e, mais importante: como se tornar mais equilibrado à medida que a tecnologia se torna mais poderosa.

A seguir está um trecho da conversa, cujo conteúdo foi editado.

Hannah Fry: Bem-vindo ao Google DeepMind, minha anfitriã é a professora Hannah Fry. Quando começamos a pensar em produzir este podcast em 2017, o DeepMind era um laboratório de pesquisa relativamente pequeno focado em IA. Quando foram adquiridos pelo Google, eles estavam trabalhando em seu próprio projeto a alguma distância, em Londres. No último trimestre, o Google reconfigurou toda a sua estrutura para colocar a sua equipe de IA no centro da sua estratégia.

Demis Hassabis: Não, absolutamente não (rindo).

Hannah Fry: Bem, muito obrigada por ter vindo. Pergunto-me: agora que o interesse público pela IA está a explodir, o seu trabalho é mais fácil ou mais difícil?

Demis Hassabis: Acho que é uma faca de dois gumes, certo. É definitivamente mais difícil porque há muito escrutínio, atenção e bastante barulho em todo o campo. Na verdade, prefiro quando há menos gente e posso me concentrar mais na ciência. Mas agora também é bom porque mostra que a tecnologia está pronta para impactar o mundo de muitas maneiras diferentes e impactar a vida diária das pessoas de uma forma positiva. Então eu acho isso emocionante também.

Hannah Fry: Você está surpreso com a rapidez com que a IA captou a atenção do público? Embora eu ache que você também esperava isso.

Demis Hassabis: Sim, exatamente, em algum momento (já esperado). Nós temos trabalhado nisso há anos, até décadas. Então acho que em algum momento todos perceberão a importância da IA. Mas ainda é muito surreal ver tudo realmente se concretizando. Acho que este é o advento dos chatbots e dos modelos de linguagem, afinal todos usam a linguagem e todos podem entender a linguagem. Portanto, esta é uma maneira fácil para o público entender e possivelmente julgar a posição da IA.

Hannah Fry: Ouvi dizer que você descreveu esses chatbots como “excessivamente úteis” e gostei muito disso. Falaremos sobre tecnologia de transformadores em um minuto, e acho que foi esse grande avanço que nos deu essas ferramentas. Mas agora quero perguntar primeiro: o que você quer dizer com “excessivamente útil”?

Demis Hassabis: Quer dizer, acho que se alguém voltar 5, 10 anos e disser que vamos fazer algo, o que vai ser é, tipo, construir uma arquitetura incrível e depois escalar a partir daí, em vez de construir a partir de algum conceito ou abstração – este é um debate que teríamos tido há 5, 10 anos, precisamos de uma forma específica de abstrair? Porque o cérebro parece fazer exatamente isso.

Mas de alguma forma, se você fornecer dados suficientes aos sistemas, digamos, toda a Internet, eles parecem aprender e generalizar a partir deles, não apenas mecanicamente, mas realmente, até certo ponto, entendem com o que estão lidando. E funciona de uma forma um tanto perceptual e um tanto irracional. Acho que ninguém teria imaginado há cinco anos que funcionava.

Hannah Fry: Sim, coisas como compreensão conceitual e abstração acontecem naturalmente, e não (sendo projetadas).

Demis Hassabis: Sim, estávamos falando sobre coisas como conceitos e fundamentação antes, fundamentando a linguagem na experiência do mundo real, talvez em um ambiente simulado, talvez em um robô inteligente incorporado, o que é realmente importante para realmente compreender o mundo que nos rodeia. O mundo é necessário. É claro que estes sistemas ainda não foram implementados. Eles cometeram muitos erros e não tinham realmente um modelo de mundo, um bom modelo de mundo. Mas eles aprenderam mais do que as pessoas esperavam apenas aprendendo com a língua.

Hannah Fry: Talvez ainda tenhamos que explicar o que é a base para os espectadores que não sabem. Porque este é um conceito muito importante.

Demis Hassabis: É claro que esta é a razão pela qual o sistema clássico de investigação sobre IA foi estabelecido em locais como o MIT nas décadas de 1980 e 1990. Você pode pensar neles como bancos de dados gigantes conectados a outras palavras. O problema é que você pode dizer que “um cachorro tem pernas” existe no banco de dados, mas quando você mostra a imagem de um cachorro, ele não sabe que a coleção de pixels aponta para aquela frase. Este é o problema que o trabalho de aterramento tem que enfrentar. Você tem essa representação abstrata de símbolos, mas no mundo real – o confuso mundo real – o que isso realmente significa? Tentamos descobrir, mas nunca está certo.

É claro que este não é o caso dos sistemas atuais, que aprendem diretamente com os dados. Então, de certa forma, eles estavam formando essa conexão desde o início. Mas o interessante é que se você aprender apenas com o idioma, em teoria, deverá estar perdendo muitos dos fundamentos necessários. Acontece que muito disso pode ser inferido.

Hannah Fry: Por que teórico?

Demis Hassabis: De onde vem esse aterramento? Esses sistemas, pelo menos os primeiros grandes modelos de linguagem, não existiam antes no mundo real. Eles não estão conectados ao emulador, não estão conectados ao bot, nem têm acesso à internet. Para começar, eles também não são multimodais, não têm habilidades visuais nem nada, apenas vivem puramente no espaço da linguagem, um reino abstrato, então é bastante surpreendente que eles possam inferir algo sobre o mundo real a partir dessas coisas.

Hannah Fry: Se as pessoas se envolverem e interagirem com o sistema e disserem claramente: "Essa é uma resposta inútil", "Essa é uma boa resposta", isso pode fornecer percepção.

Demis Hassabis: Exatamente, então certamente se derem errado, parte disso se deve à falta de fundamentação nas primeiras versões. Por exemplo, se você perguntar a um cachorro como latir e ele responder incorretamente, você o corrigirá se der feedback. Parte do feedback vem do nosso próprio conhecimento, que lentamente se infiltra no modelo.

Hannah Fry: Lembro-me de ter visto um exemplo muito bom disso, sobre "atravessar o Canal da Mancha" versus "atravessar o Canal da Mancha".

Demis Hassabis: Sim, é esse tipo de coisa, se responder errado, você dá um feedback de que está errado, e então ele tem que descobrir, você não pode cruzar o canal a pé.

Hannah Fry: Eu gostaria de perguntar: você acha que o estágio em que estamos agora, neste momento, as coisas são exageradas ou subestimadas? Ou está sendo exagerado na direção errada?

Demis Hassabis: Acho que é mais o último. Eu diria que no curto prazo foi exagerado. Há reivindicações de que é possível fazer todos os tipos de coisas que não podem ser feitas; há todos os tipos de startups e capital de risco perseguindo-os, mas eles ainda não estão prontos. Por outro lado, acho que ainda está subvalorizado, ainda não sinto que as pessoas entendam totalmente o que vai acontecer quando chegarmos ao AGI e ao pós-AGI. Isso seria algo enorme, então entenda também essa responsabilidade. Então, ambos são um pouco exagerados e acho que estamos passando por um ciclo assim.

Hannah Fry: Em comparação com todas essas startups e capital de risco em potencial, vocês (a equipe) vivem e respiram pesquisas de IA há décadas e estão em uma boa posição para identificar quais são metas realistas e quais não são. Mas para outros, como diferenciam entre o que é real e o que não é?

Demis Hassabis: Acho que, obviamente, é preciso fazer a devida diligência a nível técnico e ter algum conhecimento da tecnologia e das últimas tendências. Acho que depende também de quem fala, qual é a sua formação, quão técnico é. Eles só começaram a olhar para a IA no ano passado? Antes do ano passado, eles estavam envolvidos com criptomoedas? Estas podem ser algumas pistas.

Quando um lugar de repente atrai a atenção e o dinheiro vem com ele, todos temem que estejam perdendo alguma coisa. Isso cria um ambiente oportunista que é um pouco contrário àqueles de nós que trabalham de uma forma profundamente técnica e científica há décadas.

Hannah Fry: Sim, um dos nossos grandes tópicos é Gêmeos, e vem dessa abordagem científica muito aprofundada. De que forma o Gemini difere de outros grandes modelos de linguagem lançados por outros laboratórios?

Demis Hassabis: Desde o início queríamos que o Gemini fosse multimodal. Ele pode lidar não apenas com linguagem, mas também com áudio, vídeo, imagens, código, qualquer coisa. A razão pela qual queremos fazer isto é, em primeiro lugar, porque pensamos que, desta forma, estes sistemas podem realmente compreender o mundo que os rodeia e construir melhores modelos do mundo. Então, isso na verdade remonta ao tema que acabamos de falar, ainda estamos construindo a base, mas desta vez está em cima da linguagem.

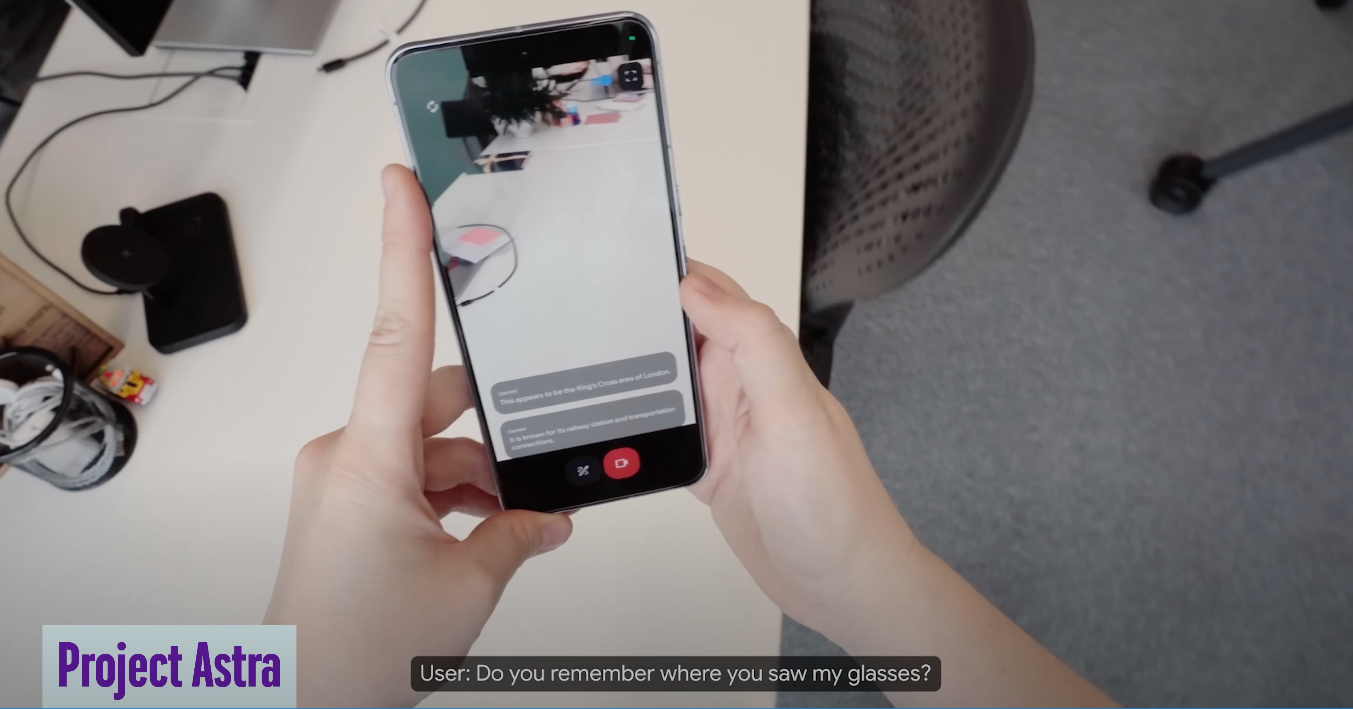

E então também tivemos a visão de ter um assistente universal e prototipamos algo chamado Astra, sobre o qual acredito que falaremos, que entende não apenas o que você está digitando, mas o ambiente em que você está.

Se você imaginar um assistente pessoal ou assistente digital, quanto mais contexto ele compreender, mais útil será a ajuda que poderá fornecer. Sempre pensamos que um sistema como esse seria mais útil. Então construímos a multimodalidade desde o início. Esse é um aspecto: ser inerentemente multimodal. E na época era o único modelo que conseguia fazer isso. Agora, outros modelos estão tentando acompanhar

E também temos algumas grandes inovações na memória, como o contexto longo, que agora pode lembrar um milhão ou dois milhões de tokens, e você pode considerá-los aproximadamente semelhantes a lembrar um milhão ou duzentas mil palavras. Você pode dar um trabalho como Guerra e Paz ou até mesmo, por causa da multimodalidade, agora você pode dar um vídeo inteiro, um filme inteiro ou uma palestra, e fazer com que ele responda a perguntas ou seja encontrado no stream de vídeo o conteúdo que você precisa.

Hannah Fry: Lembro que você deu um exemplo do Astra ajudando você a lembrar onde colocou os óculos. Mas estou curioso sobre o desenvolvimento dessas tecnologias. Será que esta é apenas uma versão avançada daqueles antigos Google Glasses?

Demis Hassabis: Claro, o Google tem uma longa história de desenvolvimento de dispositivos semelhantes ao Glass, que remonta a cerca de 2012. Então eles estão muito à frente nessa área, mas o que provavelmente está faltando é esse tipo de tecnologia que o Astra representa. Com esta tecnologia, você pode realmente compreender um agente inteligente ou assistente inteligente que entende o que vê. Estamos entusiasmados com os assistentes digitais que podem acompanhá-lo e compreender o mundo ao seu redor. Quando você o usa, parece um uso muito natural.

Hannah Fry: Ok, quero voltar um pouco às origens do Gemini. Ele veio de dois departamentos diferentes, certo.

Demis Hassabis: Sim, fundimos os dois departamentos de pesquisa da Alphabet no ano passado. Em outras palavras, fundir o DeepMind original e o Google Brain em um superdepartamento, reunindo todos os maiores talentos da nossa empresa e de todo o Google, e combinando o melhor conhecimento em todas as pesquisas, especialmente no aspecto de modelos de linguagem. Temos projetos como Chinchilla e Gopher, que construíram modelos de linguagem iniciais como Palm e Lambda, cada um com seus próprios pontos fortes e fracos. Reunimos todos eles para formar o Gemini, o primeiro projeto farol lançado pela equipe combinada. Outra coisa importante é que também reunimos todos os recursos computacionais para fazer um treinamento realmente em grande escala e centralizar os recursos computacionais. Então eu acho isso muito legal.

Hannah Fry: Acho que o foco do Google Brain e do DeepMind são diferentes em muitos aspectos, certo?

Demis Hassabis: De fato. Acho que ambos estão focados na vanguarda da IA e, embora já exista muita colaboração no nível do pesquisador individual, talvez não tanto no nível estratégico. Agora, após a fusão, descrevo o Google DeepMind como a “sala de máquinas” do Google. Na verdade, temos mais semelhanças do que diferenças na forma como trabalhamos. Continuamos a manter e a reforçar os nossos pontos fortes na investigação básica. Por exemplo, de onde virá a arquitetura Transformer da próxima geração? Queremos inventá-lo. Obviamente, o Google Brain inventou a arquitetura da geração anterior e combinamos isso com o aprendizado por reforço profundo em que fomos pioneiros. Ainda acho que há necessidade de mais inovação no futuro e acredito que podemos fazer isso, como fizemos nos últimos 10 anos, o que é emocionante.

Hannah Fry: Então, voltando ao Gemini em si, quão bom ele é em comparação com outros modelos?

Demis Hassabis: Acho que existem alguns benchmarks [que falam das suas capacidades], mas esse não é o problema, o problema é que todo o campo precisa de melhores benchmarks. Existem alguns benchmarks acadêmicos bem conhecidos, mas eles estão um pouco saturados agora e não conseguem distinguir as diferenças sutis entre os diferentes modelos de topo. Eu diria que há três modelos que estão na vanguarda no momento: nosso Gemini, o GPT da OpenAI e o Claude da Anthropic. Claro, existem outros bons modelos, como os desenvolvidos pela Meta e Mistral e outras empresas, que têm os seus próprios pontos fortes em diferentes áreas. Dependendo das suas necessidades, por exemplo, Claude pode ser mais forte para codificação, GPT pode ser melhor para raciocínio e, em termos de processamento de memória, contexto longo e compreensão multimodal, é Gemini. É claro que todos nós estamos constantemente melhorando nossos modelos. Então, considerando que Gêmeos tem apenas um ano, acho que estamos numa trajetória muito boa. Da próxima vez que falarmos sobre esse assunto, esperamos estar na vanguarda, porque estamos.

Hannah Fry: Parece que ainda há um longo caminho a percorrer, quero dizer, ainda há algumas coisas nas quais esses modelos não são muito bons.

Demis Hassabis: Sim, definitivamente. Na verdade, esse é o grande debate no momento. Portanto, este último conjunto de coisas parece estar emergindo de uma tecnologia que foi inventada há 5 ou 6 anos. O problema é que ainda faltam toneladas de coisas. Então eles, na verdade, você sabe, produzem o que conhecemos como alucinações. Eles também não são muito bons em planejamento.

Hannah Fry: Que sentido eles estão planejando? Quero dizer.

Demis Hassabis: Sim, é aí que está o debate neste momento. Esta recente série de desenvolvimentos baseia-se, na verdade, em tecnologia inventada há 5 ou 6 anos. O problema, porém, é que ainda falta muita coisa. Por exemplo, existem problemas com a sua precisão factual e sabemos que podem ter alucinações. Além disso, eles não são bons o suficiente em planejamento.

Hannah Fry: O que exatamente significa “planejamento”?

Demis Hassabis: Por exemplo, em termos de planejamento de longo prazo, você estabelece uma meta e eles ainda não podem realizar operações para você no mundo real. Portanto, eles ainda são sistemas de perguntas e respostas muito passivos. Você precisa ativá-los fazendo perguntas e então eles dão algum tipo de resposta, mas não conseguem realmente resolver o problema para você.

Se você quisesse que fosse um assistente digital, você poderia dizer 'reserve-me férias na Itália e organize todos os restaurantes, museus, etc.' . Ingressos e tratamento desses assuntos. Portanto, atualmente não pode fazer isso.

Mas penso que esta é a próxima era – aqueles sistemas que têm um comportamento mais agente, o que chamaríamos de sistemas de agentes ou sistemas que têm a capacidade de agir como agentes. É nisso que nos destacamos. Isso é o que fizemos com todos os nossos agentes de jogos, AlphaGo e outros projetos dos quais falamos no passado. Estamos combinando estas obras de prestígio com novos modelos multimodais de grande escala. Acho que é para onde irá a próxima geração de sistemas. Você pode pensar nisso como uma combinação de AlphaGo com Gemini.

Hannah Fry: Sim, acho que o AlphaGo já é muito bom.

Demis Hassabis: Sim, é muito bom em planejamento, apenas no mundo dos jogos, é claro. Portanto, precisamos integrá-lo em áreas comuns como o trabalho diário e o idioma.

Hannah Fry: Você acabou de mencionar que o Google DeepMind é agora a sala de máquinas do Google. Esta é uma grande mudança. Eu também perguntei há alguns anos: o Google está fazendo uma grande aposta?

Demis Hassabis: Sim, acho que sim. Acho que o Google sempre entendeu a importância da IA. Sundar disse quando assumiu o cargo de CEO que o Google é uma empresa que prioriza a IA. Discutimos essa questão no início de seu mandato. Ele viu o potencial da IA como a próxima grande mudança de paradigma depois da Internet móvel, ainda maior. Mas acho que nos últimos dois anos realmente começamos a viver de acordo com essa filosofia, não apenas do ponto de vista da pesquisa, mas também do produto e de outros aspectos. É muito emocionante e acho que é a escolha certa para coordenarmos todos os talentos e fazermos o nosso melhor para seguir em frente.

Hannah Fry: E o contrário? Porque penso que, do ponto de vista da DeepMind, com as suas fortes capacidades de investigação, significa que agora que se tornou a "sala de máquinas" do Google, é necessário prestar mais atenção aos interesses comerciais do que à pura investigação científica?

Demis Hassabis: Precisamos de prestar mais atenção aos interesses empresariais, o que é uma das nossas responsabilidades agora. No entanto, existem algumas coisas para falar.

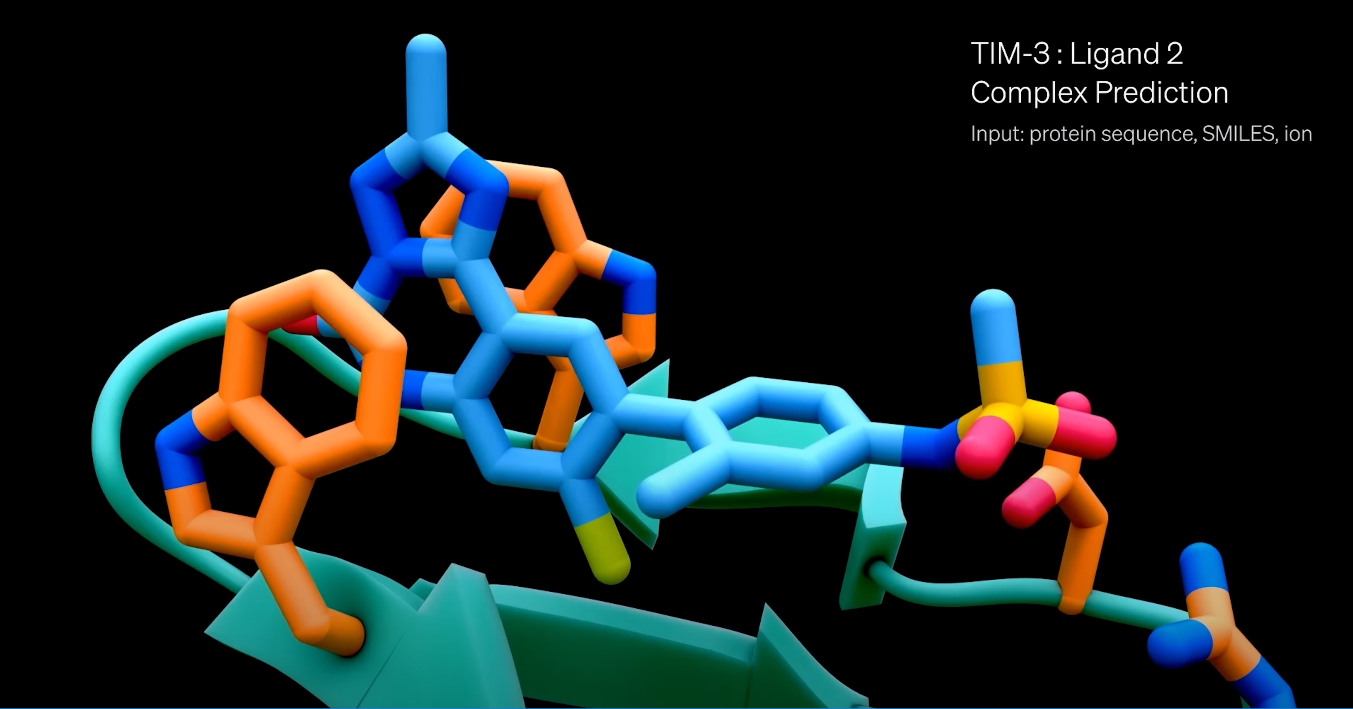

Em primeiro lugar, continuamos a nossa investigação científica, como o AlphaFold 3 foi lançado recentemente, e estamos a duplicar o nosso investimento nesta área. Acho que este é um recurso exclusivo do Google DeepMind. Até mesmo nossos concorrentes os consideram a “riqueza universal” trazida pela IA. O progresso está indo muito bem nessas frentes. Também expandimos o Isomórfico para descoberta de medicamentos, o que é muito interessante. Continuaremos a avançar nesses esforços.

Além de construir grandes modelos, Gemini, etc., também estamos construindo uma equipe de produtos para trazer todas essas tecnologias incríveis para as diversas plataformas do Google. É um privilégio incrível, pois o que inventamos pode ter um impacto imediato em um bilhão de pessoas, e isso é realmente motivador.

Na verdade, existe agora uma maior convergência entre o desenvolvimento de tecnologias de IA para utilização em produtos e aquelas necessárias para a investigação pura de IA. Cinco anos atrás, talvez você precisasse criar alguma IA especial para um produto. Ainda há algum trabalho específico do produto que precisa ser feito, mas talvez seja apenas 10% do esforço. Portanto, agora que a tensão entre o desenvolvimento de produtos de IA e a construção de AGI desapareceu, eu diria que 90% do plano de investigação é o mesmo.

Por fim, é claro, se você lançar um produto e colocá-lo em uso prático, aprenderá muito com ele. O uso do usuário pode revelar muita coisa que não corresponde exatamente ao seu julgamento interno, então você pode atualizar e melhorar o estudo, o que é muito útil.

Hannah Fry: Concordo totalmente. Neste podcast, falamos mais sobre os avanços alcançados com a aplicação da IA à ciência. Mas quero fazer uma pergunta sobre quando os resultados serão divulgados ao público. Dentro da DeepMind, essas ferramentas, como grandes modelos de linguagem, são mais usadas para pesquisa do que consideradas como potenciais produtos comerciais, certo.

Demis Hassabis: Sim, exatamente. Sempre levamos a responsabilidade e a segurança muito a sério, desde os nossos primeiros dias em 2010, e o Google adotou algumas de nossas cartas de ética em seus princípios de IA. Portanto, estamos muito alinhados com o Google como um dos líderes neste espaço e comprometidos com a implantação de tecnologia de forma responsável.

É realmente interessante agora começar a lançar produtos no mercado com IA generativa. Estamos a aprender rapidamente, o que é bom porque a tecnologia ainda se encontra numa fase de risco relativamente baixo. À medida que a tecnologia se torna mais poderosa, precisamos ser mais cuidadosos. Aprender como testar a tecnologia generativa de IA é importante para as equipes de produto. Isso difere dos testes de tecnologia normal porque a IA generativa nem sempre faz necessariamente a mesma coisa. É quase como testar um jogo de mundo aberto, e as coisas que você pode experimentar são quase ilimitadas. Então, como conduzir o red teaming torna-se muito interessante.

Hannah Fry: Nesse caso, o time vermelho está competindo entre si?

Demis Hassabis: Sim, o red teaming é formar uma equipe independente da equipe de desenvolvimento para realizar testes de estresse e tentar quebrar a tecnologia de todas as maneiras possíveis. Realisticamente, você precisa de ferramentas para automatizar esses testes porque, mesmo que dezenas de milhares de pessoas participem, isso ainda não se compara ao uso real por bilhões de usuários. Quando a tecnologia for lançada, os usuários tentarão uma variedade de coisas. Portanto, tem sido divertido aplicar esses aprendizados para melhorar nossos processos para garantir que lançamentos futuros ocorram da maneira mais tranquila possível. Precisamos fazer isso em etapas, começando com uma fase experimental, depois um beta fechado e depois um lançamento gradual, assim como fizemos com os lançamentos de jogos anteriores. Aprenda cada passo do caminho.

Além disso, devemos também fazer mais uso da própria IA para nos ajudar a realizar testes de equipe vermelha, descobrir automaticamente alguns erros ou realizar classificação preliminar, para que nossos desenvolvedores e testadores humanos possam se concentrar em lidar com essas situações complexas.

Hannah Fry: Uma das coisas realmente interessantes é que você está em um espaço mais incerto agora. Se a probabilidade de algo acontecer for muito pequena, mas se você tentar várias vezes, algo acabará dando errado. Acho que pode ter havido alguns erros divulgados.

Demis Hassabis: Sim, é por isso que mencionei que as equipes de produto estão se adaptando a essa abordagem de teste. Embora tenham testado esses sistemas, eles eram inerentemente aleatórios e incertos. Então, em muitos casos, se for um software comum, você pode dizer que testei 99,99% dos casos e depois inferir que isso é suficiente. Mas esse não é o caso desses sistemas generativos, que podem reagir de todas as maneiras inesperadas, inesperadas e nunca antes vistas.

Isso pode ser difícil se alguém inteligente ou adversário, como um hacker, decidir testar e ultrapassar seus limites. Devido à aleatoriedade do sistema de geração, mesmo que ele contenha tudo o que você disse antes, eles podem estar em algum estado especial, ou sua memória está preenchida com alguma informação específica, de modo que sua saída será anormal. Então isso tem muita complexidade, mas não é infinito. Embora existam maneiras de lidar com essas situações, elas são muito mais complexas e cheias de nuances do que os lançamentos de tecnologia tradicionais.

Hannah Fry: Lembro-me de você dizer que precisamos pensar nisso como uma forma de computação completamente diferente, desde a computação determinística que entendemos perfeitamente, até essa forma de computação mais confusa, probabilística e carregada de erros. Você acha que o público precisa ajustar um pouco seu pensamento sobre os tipos de computação que fazemos?

Demis Hassabis: Acho que sim. Talvez antes de lançarmos algo, possamos considerar a publicação de um documento principal ou algo semelhante para esclarecer quais são as expectativas do sistema, qual é o propósito do design, quais são os cenários aplicáveis e quais são as tarefas que não podem ser concluídas. muito sentido. Precisamos educar os usuários, como em alguns casos você pode usar desta forma, mas não tente essas outras coisas porque pode não funcionar. Acho que esta é uma área onde precisamos fazer melhor e os usuários precisam ser mais experientes. Na verdade, é bastante interessante.

Pode ser por isso que os chatbots surgiram do nada. Até o ChatGPT surpreendeu o OpenAI. Temos nosso próprio chatbot, e o Google também. Ao olhar para eles, percebi também que ainda apresentam muitas falhas e ainda sofrem com erros, ilusões e muitos outros problemas. Mas o que não percebemos é que, mesmo assim, ainda existem muitos casos de uso muito bons para chatbots que as pessoas consideram muito valiosos, como resumir documentos, escrever e-mails, preencher formulários, etc. Nesses cenários de uso, as pessoas não se importam, mesmo que haja alguns pequenos erros, porque eles podem ser facilmente corrigidos e economizar muito tempo. Essa é a surpresa que as pessoas encontram ao colocar essas tecnologias nas mãos das massas. Apesar das muitas falhas conhecidas desses sistemas, ainda existem casos de uso valiosos.

Hannah Fry: Então, a próxima pergunta que quero fazer é sobre código aberto. Porque quando a tecnologia está nas mãos das massas, como você mencionou, acontecem coisas realmente incríveis. Eu sei que a DeepMind abriu o código-fonte de muitos projetos de pesquisa no passado, mas parece que isso mudou com o tempo.

Demis Hassabis: Sempre apoiamos muito o código aberto e a ciência aberta. Como você sabe, abrimos o código e lançamos quase todos os projetos de pesquisa que realizamos, incluindo projetos como Transformer e AlphaGo, que publicamos nas revistas Nature e Science. AlphaFold também é de código aberto, como discutimos da última vez.

Na verdade, a partilha de informação é a forma como a tecnologia e a ciência avançam rapidamente, por isso quase sempre pensamos que é benéfico fazê-lo. Esta é a maneira geral pela qual a ciência progride. A única exceção é quando se trata de IA ou AGI poderosa, onde enfrentamos o problema da tecnologia de dupla utilização.

Portanto, a questão é que você deseja apoiar todos os bons casos de uso e os cientistas e tecnólogos bem-intencionados, e incentivá-los a desenvolver essas ideias, criticá-las, etc. Este é o caminho mais rápido para a sociedade progredir. No entanto, o problema é como limitar simultaneamente o acesso a intervenientes maliciosos que podem utilizar estes sistemas para fins indesejáveis, utilizá-los indevidamente ou transformá-los em sistemas de armas, etc.

Estes sistemas gerais podem, de facto, ser explorados desta forma e de outras formas. Não faria mal nenhum fazer isso hoje porque não creio que o sistema atual seja robusto o suficiente. Mas depois de dois ou três anos, especialmente quando você começa a adotar sistemas de agentes automatizados ou comportamento de agentes, se esses sistemas forem abusados por algumas pessoas ou mesmo por alguns bandidos, isso pode causar sérios danos. Então acho que, como coletivo, precisamos pensar sobre o que isso significa para o código aberto.

Talvez os modelos de última geração precisem de mais inspeção, talvez um ou dois anos após seu lançamento, antes de serem de código aberto. Este é o modelo que seguimos atualmente porque temos nossos próprios modelos de código aberto, como o Gemma, que são menores e não são modelos de ponta. Embora seus recursos sejam bem compreendidos no estágio atual, eles ainda são muito úteis para os desenvolvedores, pois também podem ser executados facilmente em laptops. Em resumo, as capacidades destes modelos ainda são valiosas, mas não tão poderosas como os modelos de última geração (como o modelo Gemini 1.5). Então, acho que provavelmente acabaremos adotando essa abordagem em que teremos modelos de código aberto, mas eles ficarão um ano atrasado em relação aos modelos de última geração, para que possamos realmente avaliar o desempenho desses modelos. em um ambiente aberto.

Hannah Fry: Os recursos de modelo mais recentes e avançados podem de fato ultrapassar os limites.

Demis Hassabis: Podemos observar as capacidades e os limites destes modelos. O problema com o código aberto é que se algo der errado, você não poderá desfazê-lo. Com um modelo proprietário, você pode desativar o acesso se agentes mal-intencionados começarem a usá-lo de maneira inadequada. Em casos extremos, você pode desligá-lo completamente. Mas uma vez que você abre o código de algo, você não pode voltar atrás. Esta é uma porta de mão única, então você deve ter muito cuidado ao abrir o código.

Hannah Fry: Então é possível controlar a AGI dentro dos limites de uma organização?

Demis Hassabis: Ainda não tenho ideia de como fazer isso. Especialmente quando se trata de inteligência artificial poderosa no nível AGI, que é uma IA semelhante aos níveis humanos.

Hannah Fry: Onde as instituições se enquadram no ecossistema ideal que você descreve? Se chegarmos à fase em que a AGI apoia toda a investigação científica, as instituições tradicionais ainda terão valor?

Demis Hassabis: Acho que as instituições ainda são importantes. Antes de chegar à AGI, deve ocorrer colaboração entre a sociedade civil, a academia, o governo e os laboratórios industriais. Eu realmente acredito que esta é a única maneira de chegarmos a este estágio.

Hannah Fry: O cientista da computação Stuart Russell uma vez me disse que estava um pouco preocupado porque, quando chegarmos ao AGI, pode haver uma situação em que seremos todos como os príncipes de antigamente – pessoas que não precisam fazer login Pessoas que sentam no trono e não faça nenhum trabalho, apenas viva uma vida de luxo desenfreado, sem quaisquer objetivos.

Demis Hassabis: Sim, esta é uma pergunta interessante. Talvez não seja apenas AGI, mas mais como Superinteligência Artificial (Superinteligência Artificial) ou algum outro conceito, às vezes as pessoas chamam de ASI (Superinteligência Artificial). Neste caso, poderemos viver um estado fundamental de abundância, em que poderemos ter mais liberdade naquilo que escolhemos fazer, desde que garantamos que os recursos sejam distribuídos de forma justa e racional.

O significado, então, torna-se uma grande questão filosófica. Acho que precisaremos de filósofos, até mesmo teólogos, cientistas sociais para começarem a pensar sobre isso. O que traz significado? Ainda acho que a autoatualização é importante. Não acho que ficaremos todos sentados meditando, talvez jogando no computador, quem sabe? Mas é realmente ruim? Talvez também precisemos redefinir o que é uma vida “boa”.

Hannah Fry: Acho que os príncipes de antigamente não teriam sentido nada de mal.

Demis Hassabis: Se você olhar para quem pratica esportes radicais, como escalar o Monte Everest, todos são desafios aos limites humanos. As motivações por trás dessas atividades podem estar relacionadas à busca de significado e autorrealização. Como referiu, embora estas questões ainda não possam ser discutidas em profundidade, irão mudar significativamente o nosso mundo.

Embora as tecnologias mais avançadas tenham provocado grandes mudanças, como o tratamento de doenças, a resolução de problemas energéticos, a resposta às alterações climáticas, etc., ainda enfrentamos o problema profundo do “significado”. Essa busca de sentido não se dá apenas no nível técnico, mas envolve também a filosofia, a psicologia e até mesmo o nível cultural. Precisamos de pensar sobre como a existência e o comportamento humanos serão redefinidos sob o futuro boom tecnológico.

# Bem-vindo a seguir a conta pública oficial do WeChat do aifaner: aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.