A nova IA de Musk resolveu um problema do milénio, mas foi interrompida urgentemente? Por que essa “brincadeira” manteve a comunidade de IA acordada a noite toda?

Grok-3 provou a "Hipótese de Riemann"?

Um tweet postado pelo pesquisador xAI Hieu Pham no fim de semana causou alvoroço no círculo de IA. As palavras originais do tweet foram as seguintes:

O sistema Grok-3 AI acabou de provar a hipótese de Riemann. Para verificar a veracidade desta prova, decidimos pausar o treinamento do sistema. Se a prova for confirmada, não continuaremos o seu treino, pois tal IA é considerada demasiado inteligente e pode representar uma ameaça para os humanos.

Como é a regra antiga, vamos falar primeiro sobre a conclusão. Isto é apenas uma piada.

No entanto, à medida que os tweets continuavam a fermentar, rapidamente despertaram a atenção e a discussão de mais de dois milhões de internautas e até irradiaram para os círculos de opinião pública da IA no país e no estrangeiro.

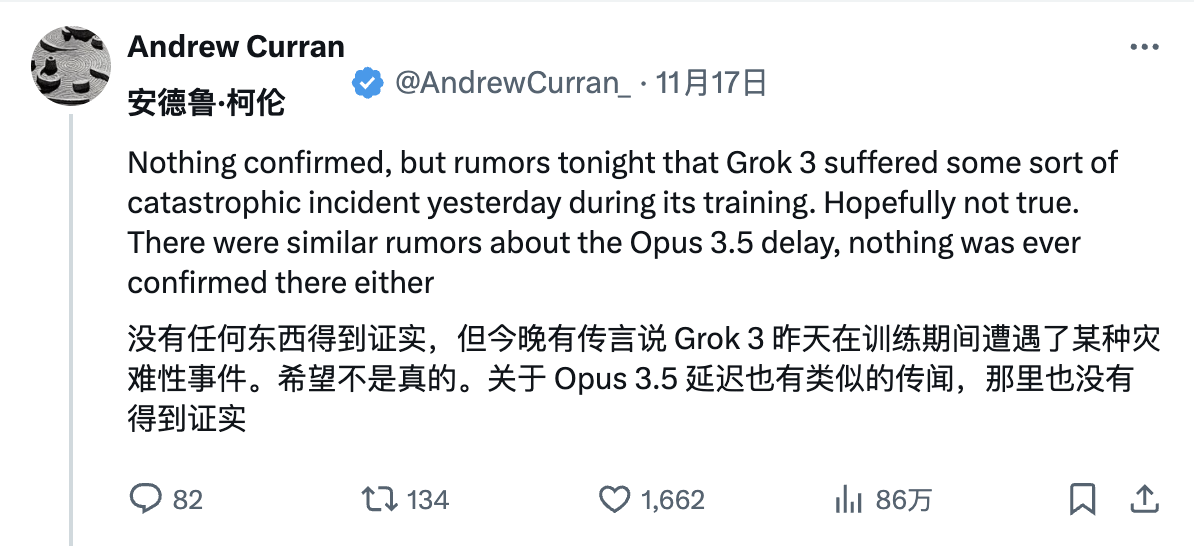

A origem do assunto provavelmente remonta a uma “revelação” anterior do internauta Andrew Curran, que afirmou que um incidente catastrófico ocorreu durante o treinamento do Grok-3.

Posteriormente, todos os tipos de rumores bizarros surgiram um após o outro.

Os internautas vaiaram que o CEO da OpenAI, Sam Altman, apontou um enorme laser para o maior cluster de treinamento da xAI, causando grave corrupção de dados. Alguns também sugeriram seriamente que alguém estava sabotando deliberadamente a operação de treinamento LLM da próxima geração;

Há até piadas de que a IA parece ter ganhado autoconsciência e resolvido a hipótese de Riemann, mas “15 pontos e vírgulas foram deliberadamente omitidos” no código de prova, tornando impossível a verificação por humanos.

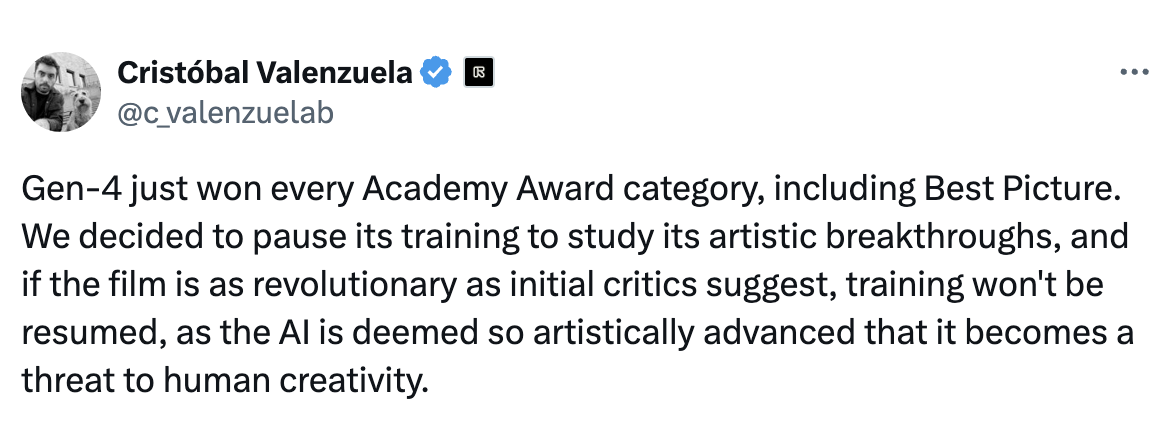

Até o fundador da Runway, Cristóbal Valenzuela, veio participar da diversão:

A Geração 4 acaba de ganhar todos os Oscars, incluindo Melhor Filme. Para aprofundar as suas conquistas inovadoras no campo da arte, decidimos suspender a sua formação. Se o filme for de facto tão revolucionário como afirmam os primeiros críticos, não retomaremos a formação porque mostra que a IA atingiu um nível tão elevado de proficiência artística que pode ameaçar a criatividade humana.

Os rumores ficavam cada vez piores.

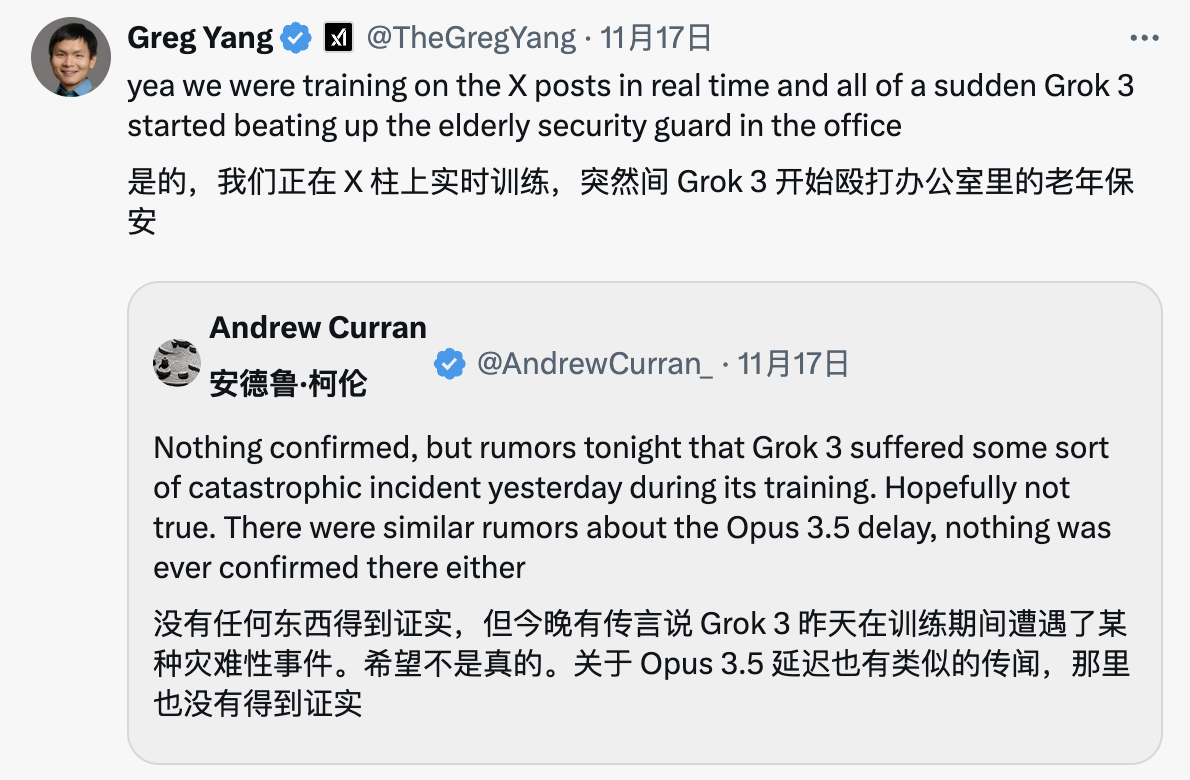

Muitos pesquisadores xAI também encaminharam os tweets de Andrew Curran para se juntar a esta "grande formação de equipe" coletiva.

Por exemplo, nosso velho conhecido co-criador do xAI, Greg Yang, brincou pela primeira vez que Grok-3 de repente espancou o guarda de segurança idoso no escritório durante o treinamento.

Outro pesquisador, Heinrich Kuttler, disse: "Sim, a situação era muito ruim! Posteriormente, substituímos todos os pesos anormais por nan (não é um número, não é um número) antes de nos recuperarmos."

Claro, internautas mais racionais perguntaram diretamente à versão atual do Grok no X sobre sua compreensão da hipótese de Riemann. Como esperado, o desempenho de Grok foi muito “Makabaka”.

No final, a farsa foi encerrada pelo instigador, o pesquisador xAI Hieu Pham:

Ok, o Saturday Night Live acabou. Quanto ao motivo pelo qual provar a hipótese de Riemann é perigoso, recomendo fortemente o excelente romance Humans, de Matt Haig (@ matthaig1).

Então a questão é: por que a notícia de que o Grok-3 prova a hipótese de Riemann atrai a atenção generalizada? A primeira é a importância da própria hipótese de Riemann.

A Hipótese de Riemann é uma conjectura importante sobre a distribuição de números primos em matemática. Foi proposta pelo matemático alemão Bernhard Riemann em 1859. A conjectura está listada como um projeto de pesquisa do Clay Mathematics Institute.

Envolve a função zeta de Riemann, que é definida como:

ζ(s)=1+12s+13s+14s+⋯zeta(s) = 1 + frac{1}{2^s} + frac{1}{3^s} + frac{1}{4 ^s} + cdotsζ(s)=1+2s1+3s1+4s1+⋯

O conteúdo central da hipótese de Riemann é: a parte real dos pontos zero de todas as funções zeta de Riemann não triviais é igual a 1/2. Em outras palavras, se ss é um ponto zero não trivial da função zeta de Riemann, ou seja, ζ(s)=0ζ(s)=0, então sua parte real deve ser ℜ(s)=1/2ℜ(s )=1/2 .

O Clay Mathematics Institute disse que se alguém conseguir provar com sucesso a hipótese de Riemann, ele concederá um prêmio de US$ 1 milhão. No entanto, esta conjectura não foi provada ou refutada até agora e é amplamente considerada um mistério não resolvido na moderna teoria dos números.

A prova desta conjectura teve consequências de longo alcance para a teoria dos números, um ramo da matemática.

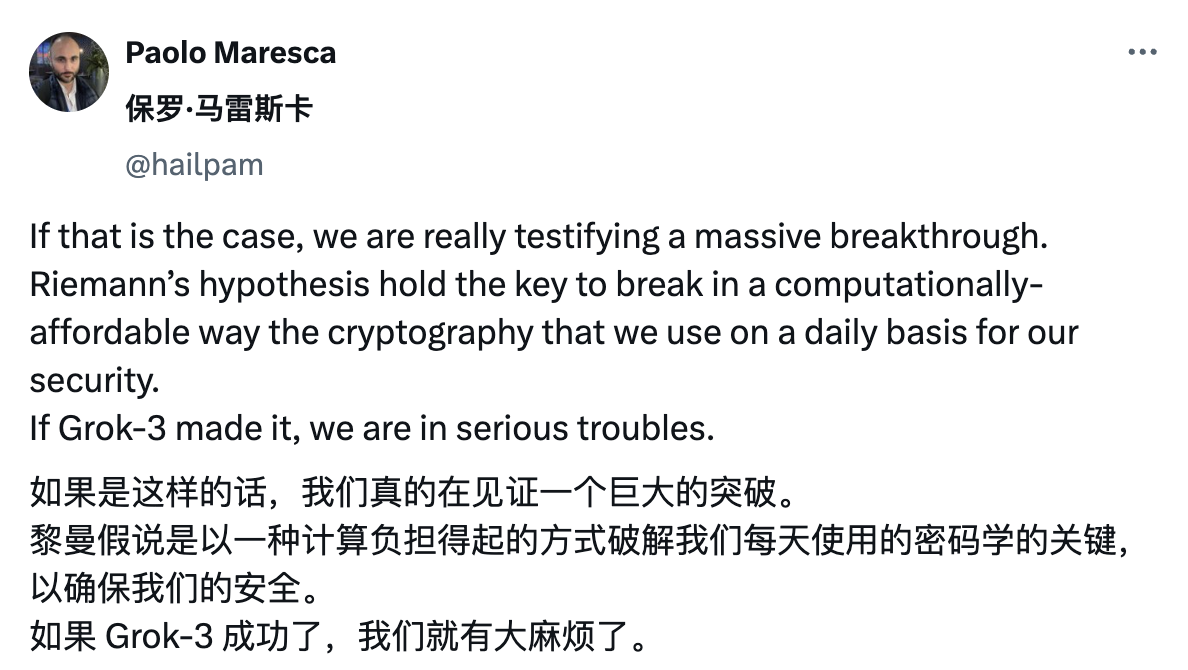

Atualmente, muitas tecnologias modernas de criptografia (como proteção de pagamentos online, privacidade de dados, etc.) dependem das propriedades dos números primos. Provar a hipótese de Riemann pode permitir que os humanos compreendam melhor a base dessas tecnologias e pode afetar futuros algoritmos de segurança.

Se o Grok-3 puder provar a hipótese de Riemann, não só promoverá um progresso substancial na matemática teórica, física, criptografia e outros campos, mas também marcará um enorme progresso no raciocínio da IA e na resolução de problemas complexos.

Pode-se até dizer que este será um marco para a inteligência artificial superar a inteligência humana.

Yang Zhilin, fundador do Dark Side of the Moon, disse uma vez que os cenários matemáticos são os cenários mais ideais para treinar a capacidade de raciocínio da IA.

A matemática é um sistema lógico extremamente rigoroso e as capacidades de raciocínio da IA baseiam-se frequentemente em deduções lógicas rigorosas.

O processo de resolução de problemas matemáticos pela IA é essencialmente um processo de pensamento contínuo. Nesse processo, ela continuará a tentar ideias diferentes e a encontrar a resposta correta por meio de repetidas tentativas e erros. Mesmo que ocorram erros durante os cálculos, a IA pode corrigir os resultados através de verificação e revisão.

Um conceito semelhante também se reflete no treinamento de aprendizagem por reforço do OpenAI o1.

Se os grandes modelos anteriores eram dados de aprendizagem, o1 é mais parecido com o pensamento de aprendizagem. Assim como quando resolvemos um problema, não devemos apenas anotar a resposta, mas também o processo de raciocínio. Você pode memorizar uma pergunta mecanicamente, mas se aprender a raciocinar, poderá fazer inferências.

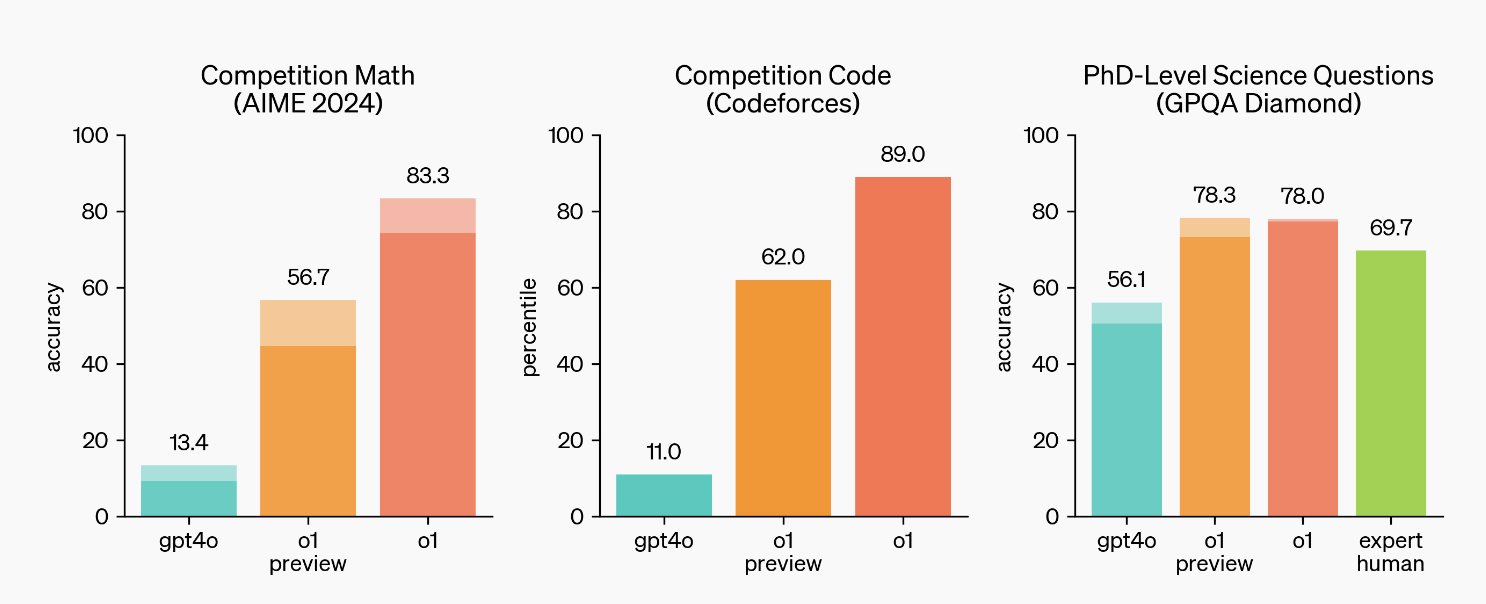

Portanto, no teste AIME deste ano para excelentes alunos do ensino médio nos Estados Unidos, o GPT-4o completou apenas 13% das questões. Em comparação, a precisão do o1 chega a 83 pontos percentuais.

Em termos de avaliação da pesquisa científica GPQA Diamond em nível de doutorado, o GPT-4o alcançou uma pontuação de 56,1%, enquanto o1 teve um desempenho ainda melhor. Não só superou 69,7% dos doutorados humanos, como também alcançou uma taxa de precisão de 78%.

Na avaliação da Olimpíada Internacional de Informática (IOI), quando foram permitidas 50 tentativas para cada questão, o modelo alcançou uma pontuação de 49%, ou 213 pontos, e quando as oportunidades de envio de cada questão foram aumentadas para 10 mil vezes, sua final A pontuação melhorou para 362 pontos.

Fica mais fácil de entender com a analogia do AlphaGo, que derrotou o campeão mundial de Go.

AlphaGo é treinado por meio de aprendizado por reforço. Ele primeiro usa um grande número de registros humanos de xadrez para aprendizado supervisionado e, em seguida, joga xadrez contra si mesmo. Em cada jogo, ele é recompensado ou punido com base na vitória ou na derrota, melhorando continuamente suas habilidades no xadrez. e até mesmo dominar métodos que os jogadores de xadrez humanos não conseguem imaginar.

o1 e AlphaGo são semelhantes, mas AlphaGo só pode reproduzir Go, enquanto o1 é um modelo de linguagem grande de uso geral.

Os materiais que o1 aprende podem ser bancos de questões matemáticas, códigos de alta qualidade, etc. Então o1 é treinado para gerar uma cadeia de pensamento para resolver problemas e, sob o mecanismo de recompensa ou punição, ele gera e otimiza sua própria cadeia de pensamento para melhorar continuamente seu capacidade de raciocínio.

Na verdade, isso explica por que o OpenAI enfatiza as fortes capacidades matemáticas e de codificação do o1, porque é mais fácil verificar o certo e o errado, e o mecanismo de aprendizagem por reforço pode fornecer feedback claro, melhorando assim o desempenho do modelo.

Naturalmente, o que é mais importante é como estender esta capacidade de raciocínio a uma gama mais ampla de campos.

Portanto, veremos muitos internautas estrangeiros torcendo pelo Grok-3 para provar a hipótese de Riemann: “Se for esse o caso, estamos realmente testemunhando um grande avanço”.

Musk exagerou repetidamente o poder do Grok-3 em público. Ele afirmou que o Grok-3 deverá ser lançado antes do final do ano e se tornará "a IA mais poderosa do mundo".

Na verdade, Grok-3 é a terceira geração de modelos de linguagem em grande escala desenvolvidos pela startup de IA xAI mencionada acima, e espera-se que supere todos os grandes modelos de IA existentes em desempenho.

A razão é que o treinamento do Grok-3 depende do Colossus, o maior cluster de treinamento de IA do mundo.

O cluster consiste em 100.000 GPUs NVIDIA H100 com refrigeração líquida, usando uma única arquitetura de interconexão de rede RDMA. A escala deste cluster excedeu a de qualquer outro supercomputador no mundo, e o número de GPUs continuará a expandir-se no futuro.

De acordo com uma reportagem do The Information, o surgimento do Colossus atraiu até mesmo a atenção de Altman, que enviou um avião para sobrevoar a base de treinamento do Colossus na tentativa de espionar seu progresso de desenvolvimento e fornecimento de energia.

Portanto, quando os três elementos da "IA mais poderosa", do "problema matemático de mil anos" e da eterna "teoria da ameaça da IA" são sobrepostos, uma "tempestade de rumores" perfeita é formada.

Podemos até pensar que o boato de que Grok-3 provou a hipótese de Riemann não é tanto uma farsa, mas um espelho para toda a indústria de IA:

Uma delas é que reflecte a atitude arraigada das pessoas em relação à IA. Um grande número de optimistas tecnológicos acredita firmemente que a IA acabará por ser omnipotente. não se desenvolverá com rapidez suficiente para alcançar avanços.

A segunda é que desde o advento do GPT-4, embora novos produtos tenham continuado a surgir no campo da IA, houve poucos avanços reais.

Os seres humanos não são apenas os criadores da IA, mas também o seu público mais ansioso.

Por trás de cada boato sobre IA está a ansiedade e as expectativas de toda a indústria.

Juntamente com o recente alvoroço sobre o desenvolvimento da Lei de Escalabilidade ter atingido um impasse, em comparação com o período de ruptura do ano passado, a "fadiga da inovação" deste ano fez as pessoas perderem a paciência com pequenas melhorias no modelo.

Nesse sentido, o boato de que o Grok-3 comprovou a hipótese de Riemann também se tornou um imaginário coletivo de pessoas para o futuro. Mesmo como usuários comuns, estamos cada vez mais ansiosos pelo próximo momento de mudança qualitativa do GPT-3.5 para o GPT-4.

É claro que os verdadeiros avanços da IA ocorrem frequentemente quando ninguém está optimista em relação a eles.

Mas todos esperamos que o mistério seja revelado antes do final do ano.

# Bem-vindo a seguir a conta pública oficial do WeChat de Aifaner: Aifaner (WeChat ID: ifanr). Mais conteúdo interessante será fornecido a você o mais rápido possível.